- Introducción y conclusiones clave

Este informe resume los resultados del seguimiento realizado entre el 1 de octubre de 2025 y el 31 de diciembre de 2025 en el marco del proyecto ATAFIMI, cuyo objetivo es detectar y analizar los casos de manipulación de la información y de injerencia en el espacio informativo (FIMI) procedentes de Rusia en diferentes países e idiomas. El seguimiento abarcó los siguientes países participantes: España, Ucrania, Lituania, Georgia, Bosnia y Herzegovina, Serbia, Argentina, Colombia, México y Venezuela.

Tesis principales:

- La narrativa desinformativa más notable durante este periodo fueron los ataques contra el ejército ucraniano y los militares extranjeros que luchan por Ucrania: las publicaciones con afirmaciones falsas acumularon más de dos millones de visitas.

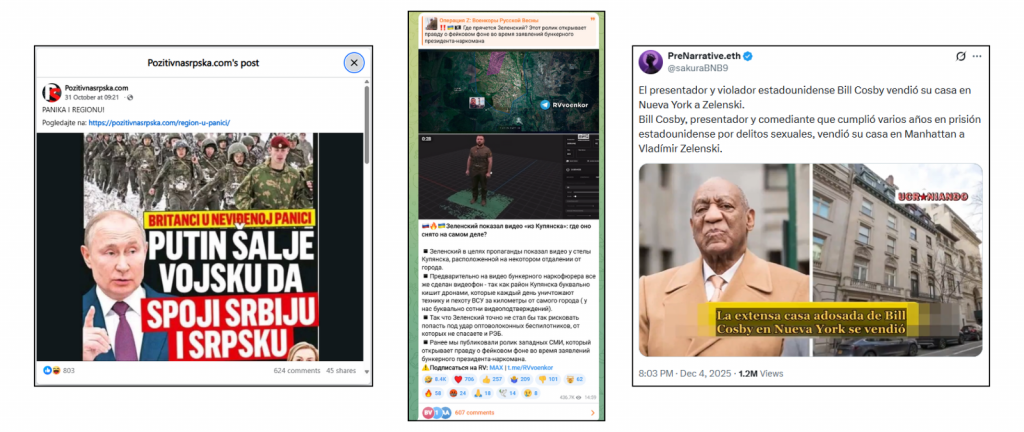

- Las acusaciones infundadas contra Volodímir Zelenski y las narrativas sobre corrupción volvieron a cobrar impulso y se registraron en 9 de los 10 países estudiados. Por ejemplo, las publicaciones sobre el supuesto pasaporte ruso o la compra de la casa de Bill Cosby fueron vistas más de 3 y 1 millones de veces, respectivamente.

- El contenido creado con IA se utilizó ampliamente para respaldar afirmaciones desinformativas. La mayoría de las publicaciones virales fueron refutadas por verificadores independientes en Facebook y, en ocasiones, recibieron advertencias de TikTok sobre contenido generado por IA. En cambio, en X solo apareció una nota de la comunidad, y en Telegram no hubo ninguna advertencia.

- Algunos de los usuarios que difundían desinformación en X tenían insignias de verificación, que ahora indican una suscripción de pago y suelen dar más visibilidad al contenido.

- Narrativas transfronterizas

El último trimestre de 2025 se caracterizó por el uso de narrativas ya existentes, respaldadas por afirmaciones desinformativas dirigidas contra las autoridades ucranianas, así como por la aparición de nuevas narrativas que tuvieron mayor repercusión en los países de América Latina.

Narrativas nuevas

Durante el período de seguimiento, aparecieron narrativas notables centradas en el tema del reclutamiento para el ejército ucraniano y las bajas humanas de la guerra.

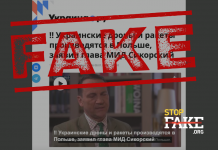

Por un lado, se difunde desinformación sobre la movilización y el reclutamiento, así como sobre las supuestas pérdidas masivas de Ucrania en las Fuerzas Armadas. Estas narrativas se ven reforzadas por noticias falsas sobre el supuesto secuestro de jóvenes o personas mayores, imágenes emotivas de soldados llorando, así como conflictos internos ficticios o actos de violencia. Algunas de estas publicaciones han obtenido más de 3 millones de visitas.

Ejemplos de afirmaciones desinformativas detectadas en el marco de estas narrativas:

| Afirmación refutada: | La afirmación se difundió en los siguientes países:: |

| Un soldado ucraniano graba un vídeo en el que llora tras ser reclutado a la fuerza para la guerra: “No quiero morir” | España, Lituania, Serbia, Venezuela, Ucrania, Georgia, México y Argentina |

| Ucrania envía a jóvenes de 17 años a defender Pokrovsk | Ucrania, México y España |

| Soldados ucranianos mataron a dos civiles que llevaban una bandera blanca y un perro con la ayuda de un dron | Lituania y México |

Estas narrativas aparecen junto con otra tendencia que se dirige directamente contra los militares extranjeros o los posibles voluntarios que luchan en el ejército ucraniano. Las afirmaciones desinformativas sobre el supuesto maltrato a los voluntarios extranjeros se difundieron ampliamente tanto en Europa como en América Latina con el objetivo evidente de disuadir a nuevos reclutas de alistarse en el ejército.

Esta tendencia de narrativas desinformativas se ha documentado en una investigación conjunta realizada en el marco de este proyecto. Es especialmente revelador que parte de este contenido se centre específicamente en los voluntarios de América Latina y se difunda activamente en esta región.

| Afirmación refutada: | La afirmación se difundió en los siguientes países: |

| Soldado brasileño que lucha en Ucrania: “Por Dios, no debería haber venido aquí” | España y México |

| Mercenario sirio visto rezando en una tienda de alimentación ucraniana | Ucrania y Georgia |

| Como resultado del ataque ruso al aeródromo de Starokostiantyniv, “murió un militar estadounidense” | Ucrania |

Además, los socios registraron el uso repetido de medios creados con IA para respaldar narrativas sobre pérdidas humanas y supuestos abusos. En concreto, se trata de vídeos con “militares” que supuestamente declaran la movilización forzosa o expresan su pesar por participar en la guerra.

Este es un aspecto importante en el contexto de las tácticas, técnicas y procedimientos (TTP) que se han identificado como herramientas clave para promover estas narrativas.

Narrativas repetidas

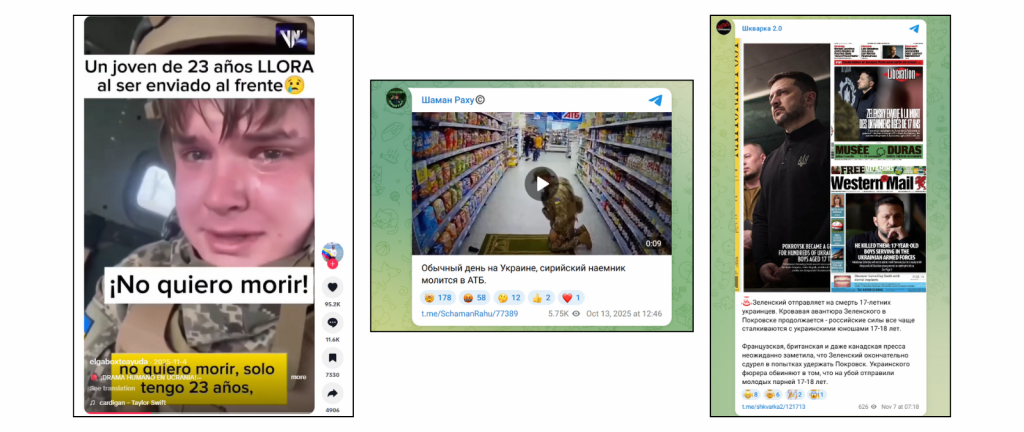

Durante este período, se utilizaron activamente narrativas ya existentes destinadas a socavar la confianza en el presidente Zelenski y su liderazgo, en particular afirmaciones sobre el supuesto uso indebido de los recursos en tiempos de guerra y la corrupción entre las élites políticas y las autoridades. Su influencia es probablemente más fuerte en los países europeos que proporcionan ayuda financiera a Ucrania.

También se registraron en diferentes países nuevas afirmaciones similares a las que ya se habían detectado anteriormente en el marco de este proyecto. Por ejemplo:

| Afirmación refutada: | La afirmación se difundió en los siguientes países: |

| Zelenski transfiere cada mes 50 millones de dólares a un banco de los Emiratos Árabes Unidos | Lituania, México, España, Venezuela, Georgia, Ucrania |

| Zelenski compró un rancho por valor de 79 millones de dólares y se convirtió en uno de los 10 mayores terratenientes de Estados Unidos | España, Lituania y Serbia |

| “Olena Zelenska gastó más de un millón de euros en ropa de diseño”, su estilista | Ucrania, Lituania y Georgia |

3.Tendencias por países

Europa

Bosnia y Herzegovina

Parte de las afirmaciones desinformativas detectadas se adaptaron claramente al público de Bosnia y Herzegovina mediante el uso de la historia local, las instituciones y la sensibilidad étnica. Entre ellas se encuentran las falsas advertencias sobre los supuestos planes de Putin de enviar tropas para “unificar Serbia y la República Srpska” (una de las dos entidades políticas de Bosnia y Herzegovina, junto con la Federación de Bosnia y Herzegovina), así como las afirmaciones de que Serbia y Croacia son los “verdaderos garantes” del Acuerdo de Paz de Dayton (1995).

Se adaptó por separado una historia en la que los supuestos incidentes con drones en Polonia y Estonia se presentaban como “operaciones bajo bandera ajena”, con comparaciones con las afirmaciones manipuladoras sobre las tragedias del mercado de Markale y la calle Vaso Miskin durante la guerra de Bosnia de los años noventa. Gran parte de este contenido fue publicado por la agencia estatal rusa Sputnik, que tiene una fuerte presencia en Bosnia. Los materiales de desinformación más virales se difundieron en Facebook y posteriormente fueron etiquetados por organizaciones independientes de verificación de datos.

Serbia

Las afirmaciones desinformativas más virales de la región se difundieron en Facebook e Instagram. Más de 6.600 usuarios dieron “me gusta” a una publicación con información falsa sobre la supuesta captura de oficiales militares de la OTAN por parte del ejército ruso (esta información falsa fue desmentida por verificadores de datos en agosto y marcada en la plataforma).

Otras publicaciones virales iban dirigidas contra el presidente Zelenski, como las afirmaciones falsas sobre un supuesto pasaporte israelí, un apartamento en Rusia o un rancho en Estados Unidos, que obtuvieron cientos de “me gusta”.

Un vídeo creado con IA en el que una “ucraniana” supuestamente pide que continúe la guerra, mientras que sus hijos viven en Polonia y Alemania, obtuvo 98.000 visitas. Este vídeo también se registró en Georgia.

Georgia

Las publicaciones virales en Facebook, que fueron vistas casi 2 millones de veces, contenían vídeos creados por IA en los que se mostraba a militares ucranianos, así como a hombres —agentes de policía y empleados de centros territoriales de reclutamiento— en un contexto provocativo.

Este contenido coincide con la misma narrativa orientada de otra noticia falsa desmentida, en la que cuentas en Facebook en georgiano y ruso difundieron una “encuesta” que supuestamente situaba a los ucranianos en primer lugar en el mundo en cuanto a nivel de homosexualidad.

La IA también se utilizó para crear contenido falso que respaldaba las afirmaciones sobre la supuesta huida de los comandantes ucranianos del campo de batalla.

Lituania

En Facebook se difundió una publicación con más de 980 reacciones y 189 reenvíos en la que se afirmaba que “Lituania lanza globos meteorológicos sobre su propio territorio para limitar el tránsito hacia Kaliningrado”. Al mismo tiempo, las autoridades nacionales confirmaron que estos globos llegan al territorio de Lituania desde Bielorrusia.

Otra teoría conspirativa difundida en Facebook (más de 60 000 visitas) intentaba convencer de que los judíos supuestamente “tomaron el control” del Gobierno del presidente de Ucrania, Volodímir Zelenski, con el objetivo de restaurar el Estado medieval de Khazaria.

También en Facebook, una publicación con 465 reacciones difundía afirmaciones falsas sobre el supuesto uso de símbolos nazis en los uniformes del ejército ucraniano, una de las narrativas que Rusia lleva promoviendo sistemáticamente desde hace mucho tiempo.

Ucrania

Los materiales de desinformación más notables en Ucrania se difundieron a través de Telegram. Los canales pro-Kremlin cuestionaron la visita del presidente Volodímir Zelenski a Kupiansk (región de Járkiv) el 12 de diciembre de 2025 (más de 430.000 visitas), y manipularon el tema de su discurso en la Asamblea General de la ONU a finales de 2025, afirmando sin fundamento que las emisoras ucranianas habían manipulado digitalmente el vídeo. En general, estas narrativas acusaban a Ucrania de manipulación informativa.

En la misma plataforma se encontró un vídeo montado en el que supuestamente militares ucranianos amenazaban a Erika Kirk, viuda del activista estadounidense Charlie Kirk, tras sus declaraciones sobre Ucrania. También se difundieron ampliamente afirmaciones desinformativas sobre la situación jurídica de los refugiados ucranianos.

Por otra parte, la propaganda histórica obtuvo más de 11.000 visitas en VK, la red social más popular de Rusia. En el vídeo, el ministro de Asuntos Exteriores de Rusia, Serguéi Lavrov, afirmaba que Odesa y Mykolayiv “fueron creadas por el pueblo ruso”, reforzando así las narrativas desinformativas históricas ya establecidas. También se afirmaba que ambas regiones de Ucrania supuestamente deseaban unirse a Rusia.

España

En España, las publicaciones desinformativas más virales se difundieron a través de X, y solo una de ellas fue marcada mediante una nota de la comunidad. Dos publicaciones con afirmaciones falsas de que Zelenski supuestamente había comprado la casa adosada de Bill Cosby en Nueva York por 29 millones de dólares y un rancho por 79 millones de dólares obtuvieron en conjunto alrededor de 2 millones de visitas.

Un nivel de alcance similar tuvo un vídeo creado con IA (sin marcar), en el que supuestamente un militar brasileño llora y lamenta haberse alistado en el ejército ucraniano.

América Latina

Argentina

En el TikTok argentino, se difundió un vídeo creado con IA que obtuvo más de 170.000 visualizaciones y afirmaba que la guerra en Ucrania había terminado, mostrando las celebraciones de civiles y militares. Un vídeo muy similar en ucraniano obtuvo 373.700 visualizaciones. La plataforma marcó automáticamente el primer vídeo como creado por IA, mientras que el segundo fue marcado por el propio usuario.

Colombia

El contenido más viral en la región se centró en la narrativa sobre la supuesta gran cantidad de mercenarios y voluntarios colombianos que luchan en el ejército ucraniano. Diversas afirmaciones desinformativas se construyeron en torno a esta narrativa y, en ocasiones, coincidían con mensajes políticos y retórica prorrusa; por ejemplo, uno de los tuits sobre este tema obtuvo más de 153.000 visitas.

Además, un vídeo creado con IA generativa (en particular, servicios para crear vídeos y audios hiperrealistas), publicado por la cuenta de TikTok Ukraine is Death, ya eliminada, mostraba falsamente la supuesta captura de militares colombianos por parte de Rusia y obtuvo alrededor de 1,6 millones de visitas.

Por otra parte, se hizo muy viral una publicación de una cuenta verificada dedicada al presidente de Colombia, en la que se afirmaba que Putin supuestamente apoyaba a Colombia y Venezuela y “detendría la invasión de Estados Unidos en la región del Caribe”. Esta publicación obtuvo más de 82.000 “me gusta” y no fue moderada por la plataforma.

México

Dos vídeos de TikTok con contenido generado por IA —uno con un “soldado ucraniano” llorando tras ser movilizado y otro con un “voluntario” que lamenta haber participado en la guerra— superaron los tres millones de visualizaciones sin ninguna advertencia.

Otras dos publicaciones virales en Facebook promovían narrativas sobre la supuesta rendición masiva de los militares ucranianos, y solo una de ellas tenía una etiqueta con una refutación.

En X tampoco había advertencias junto a las afirmaciones desinformativas sobre el supuesto pasaporte ruso de Zelenski o las visitas simuladas a ciudades que supuestamente no había visitado.

Venezuela

El canal de Telegram Venezuela News, que pertenece a un sitio web venezolano que difunde regularmente desinformación prorrusa y tiene más de 56.000 suscriptores, publicó un artículo en el que se afirmaba que un soldado ucraniano de 23 años lloró tras ser reclutado a la fuerza. El mismo artículo fue publicado en X por varias cuentas con la insignia azul X Premium y se difundió en varios países.

Información sobre el proyecto

Este informe forma parte del proyecto ATAFIMI. Mediante la creación de una herramienta tecnológica innovadora para investigar la FIMI (manipulación de información extranjera e interferencia) y las campañas transfronterizas de desinformación, el sistema centraliza y funciona como un repositorio de contenidos desinformativos detectados en los países participantes. El uso de una metodología común permite detectar campañas transfronterizas de desinformación, así como narrativas que se difunden simultáneamente en Europa y América Latina.

El proyecto tiene como objetivo detectar y analizar casos de manipulación e interferencia de la información, procedentes en particular de Rusia, en diferentes países y entornos lingüísticos.

De hecho, funciona como un sistema centralizado de recopilación y análisis de desinformación: los socios transfieren el contenido detectado a un repositorio común, lo que permite rastrear cómo se difunde la misma desinformación entre países.

El proyecto incluye las siguientes organizaciones: Fundación Maldita.es (España), StopFake (Ucrania), Delfi (Lituania), Myth Detector (Georgia), Zašto ne (Bosnia y Herzegovina), RasKRIKavanje y FakeNews Tragač (Serbia), Chequeado (Argentina), La Silla Vacía (Colombia), Verificado.mx (México) y Cazadores de Fake News (Venezuela).