Вероятнее всего, распространяемый видеоролик с «волонтером» — подделка, созданная с помощью искусственного интеллекта. Проверка с использованием инструментов DeepFake-o-meter, Attestiv и Video AI Detector показала высокую вероятность того, что изображение и звук синтетические. Видео содержит типичные признаки deepfake – неестественные движения губ и глаз, размытые черты лица и несинхронность речи.

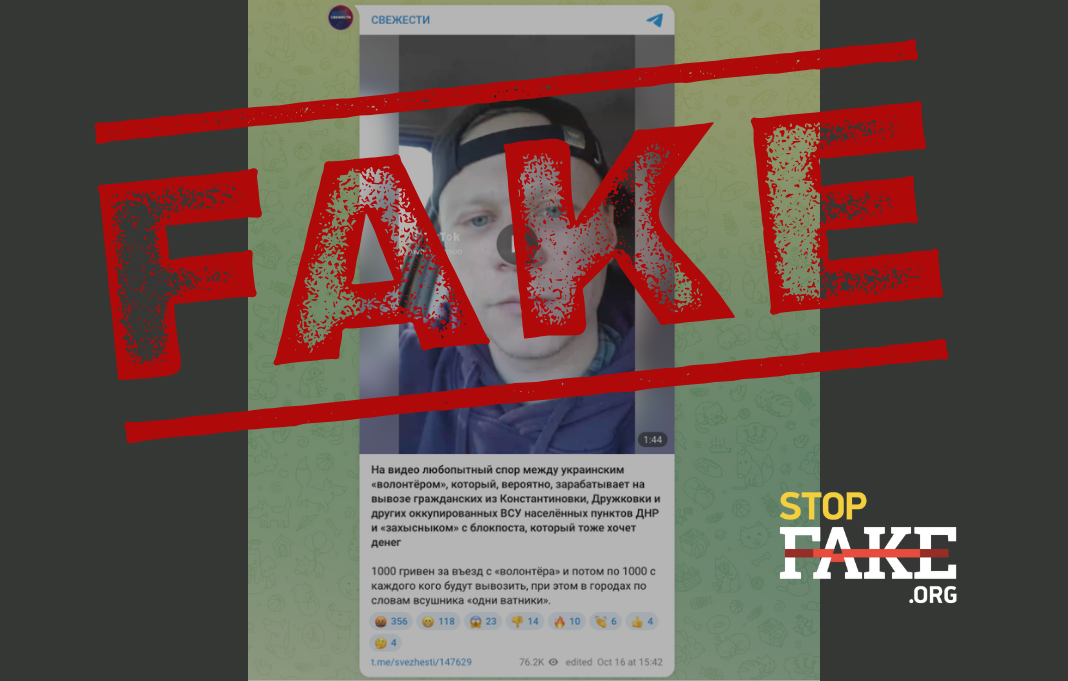

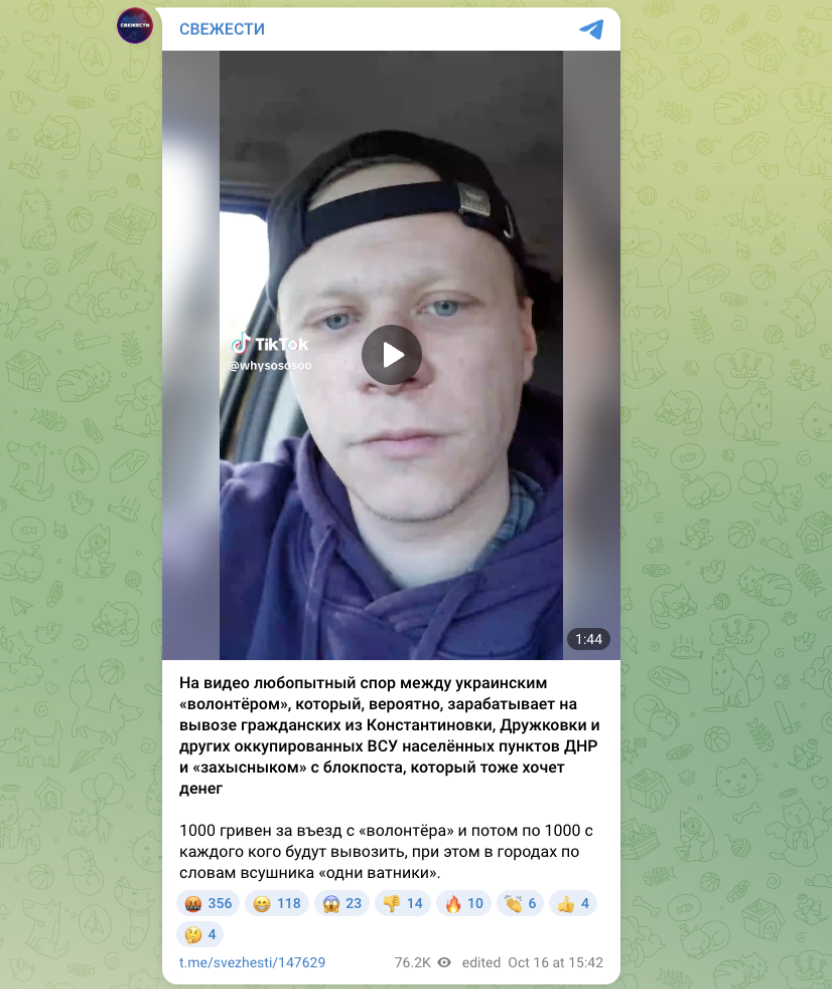

Пользователи сети распространяют видеоролик якобы волонтера, который утверждает, что украинские военные берут по 1000 гривен с каждого человека за въезд и выезд из прифронтовых городов. Во второй части видео показаны якобы кадры, снятые скрытой камерой, где «военный» требует деньги с «волонтёра» за вывоз из города «ватников» и говорит, что эти средства нужны ему на топливо и одежду.

Видеоролик состоит из двух частей. В первой мужчина, представившийся волонтером, рассказывает, что на одном из блокпостов у него якобы потребовали 1000 гривен за въезд в город, а затем еще по 1000 гривен за каждого вывезенного человека. Во второй части показан «разговор» с якобы украинским военным, который требует деньги и заявляет, что все гражданские, оставшиеся в городе, – «сепары».

Описанная ситуация, скорее всего, выдумана, а сам видеоролик, по всей видимости, создан в пропагандистских целях.

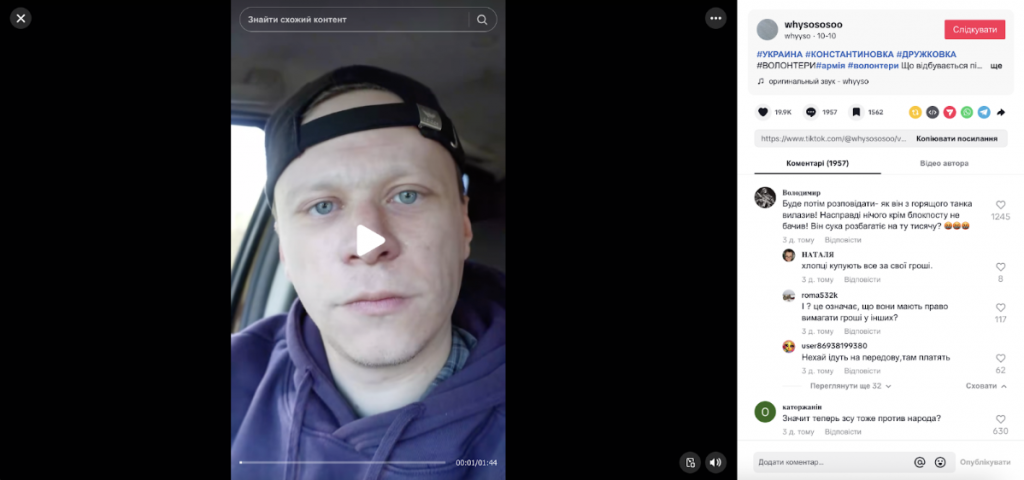

Первым это видео опубликовал анонимный профиль в TikTok – @whysososoo 10 октября. Его водяной знак можно заметить на всех распространенных копиях ролика. Примечательно, что видео с «волонтером» – единственная оригинальная публикация этого аккаунта. Остальные записи – это репосты танцевальных роликов. В профиле нет ни имени, ни контактной информации, ни признаков того, что страницу ведет человек, занимающийся волонтерской деятельностью. На данный момент видео набрало около 20 тысяч лайков и 2 тысяч комментариев.

Также показательно, что этот видеоролик распространяют исключительно прокремлевские Telegram-каналы. По данным сервиса Osavul, впервые в Telegram его опубликовал канал «Свежести» 16 октября, после чего ролик начал активно тиражироваться в сети.

StopFake не удалось установить личность мужчины, изображенного на видео. Однако тщательный анализ указывает на то, что ролик создан с использованием искусственного интеллекта.

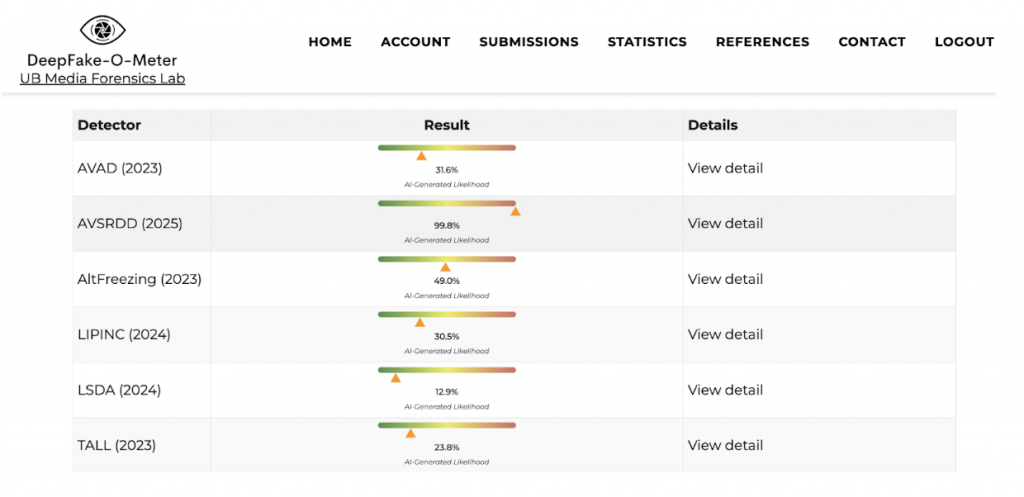

StopFake проверил видео с помощью инструмента DeepFake-o-meter (Университет Буффало), который анализирует фото, видео и аудио на предмет манипуляций с применением ИИ. Для надежности ролик был протестирован несколькими различными алгоритмами.

Результаты анализа показали, что видео с высокой вероятностью является искусственно сгенерированным. Один из детекторов – AVSRDD, специализирующийся на анализе синхронизации звука и изображения, – продемонстрировал почти 100% уверенность в том, что это deepfake. Другие модели показали от низких (10–31%) до средних (49%) показателей вероятности подделки. Еще один алгоритм зафиксировал несоответствие движения губ речи, что также указывает на искусственное происхождение видео.

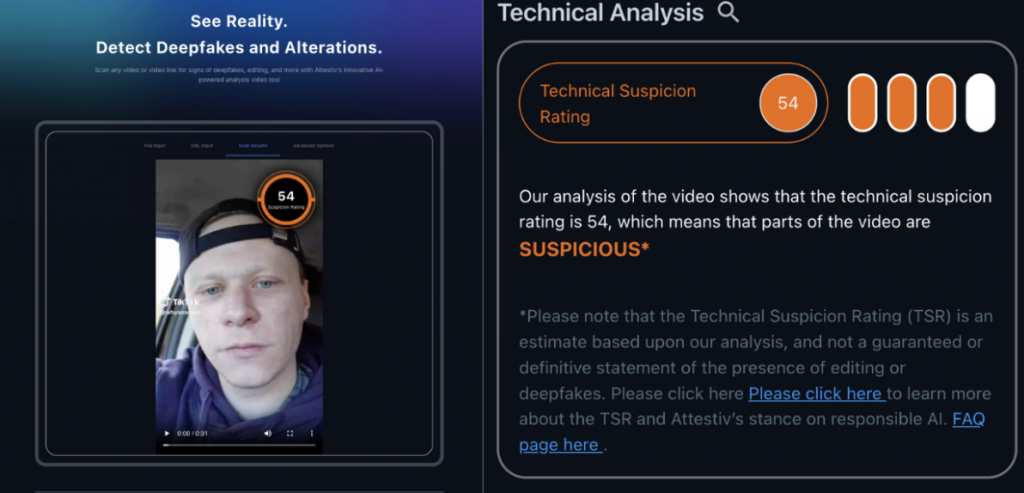

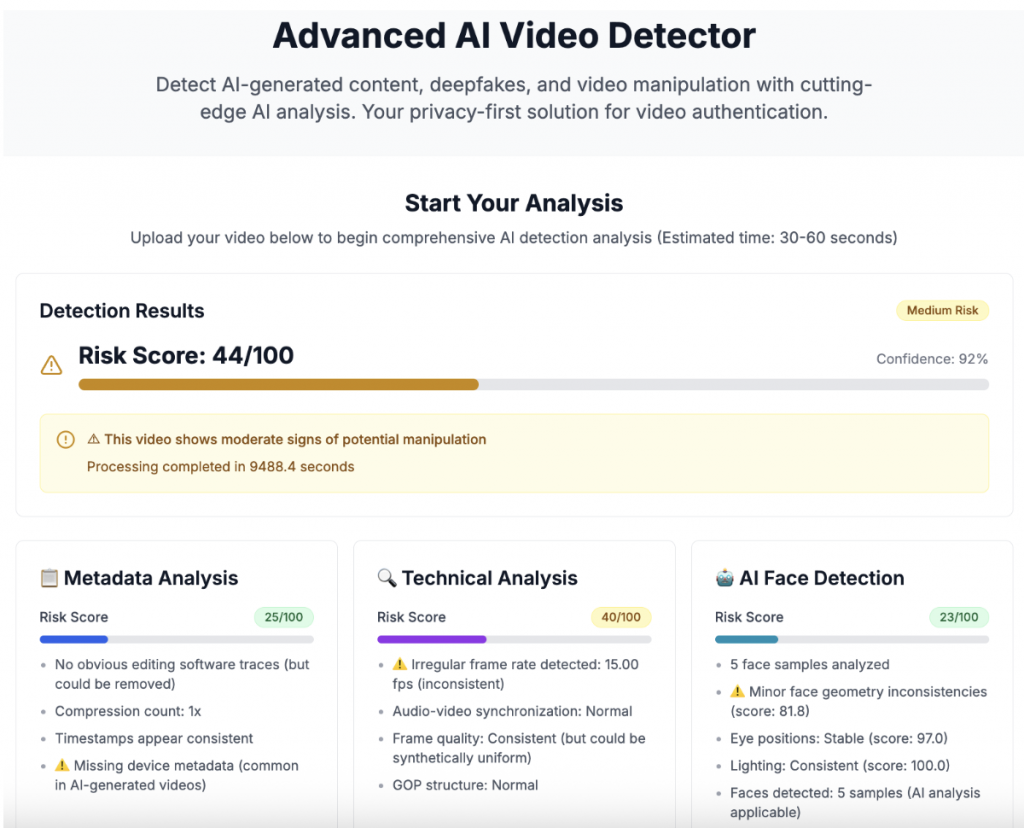

Другие сервисы, такие как Attestiv и Video AI Video Detector, также показали высокие показатели подозрительности – 54 и 44 балла соответственно. Это означает, что отдельные части видео, вероятнее всего, были созданы при помощи нейросетей.

Даже без инструментального анализа можно заметить неестественные движения губ и глаз, а также размытые черты лица – характерные признаки синтетического изображения.

Вторая часть ролика, где «волонтер» якобы скрытно записывает разговор с военным, также выглядит постановочно. На это указывают театральность поведения участников, неестественная интонация и акцент, что позволяет предположить, что украинский язык для них не родной. Кроме того, «волонтер», сидящий за рулем автомобиля, в какой-то момент говорит кому-то «разворачивайся» – что нелогично, ведь он сам управляет машиной. На видео не видно лиц собеседников, а также самого блокпоста, что делает невозможным идентификацию участников ситуации и обстоятельств.

StopFake не удалось найти никаких доказательств того, что украинские военные действительно требовали деньги с гражданских или волонтеров на блокпостах. Эвакуация из упомянутых в публикациях городов – Дружковки и Константиновки – осуществляется бесплатно силами местных властей и Государственной службы Украины по чрезвычайным ситуациям.

Таким образом, никаких подтверждений подлинности описанной истории нет.

Подобные ролики создаются для дискредитации украинских военных и волонтеров, а также для подрыва доверия к украинскому государству. Под видом «разоблачений» такие видео формируют представление о коррупции, хаосе и моральном упадке в украинском обществе, усиливая утомление и разочарование аудитории. Их конечная цель – ослабить поддержку Украины как внутри страны, так и за ее пределами.

Ранее StopFake анализировал созданное с помощью нейросети фейковый видеоролик о якобы мобилизации людей с синдромом Дауна в ВСУ.