Видеоролики не являются подлинными и были сгенерированы с помощью искусственного интеллекта. На роликах заметны типичные признаки AI-контента: размытые лица, ошибки в экипировке и символике, неправильные цвета флага Украины и отсутствие естественного движения губ. Техническая проверка с помощью DeepFake-O-Meter показала крайне высокую вероятность AI-генерации. Массовое и однотипное распространение этих видео указывает на целенаправленную информационную атаку.

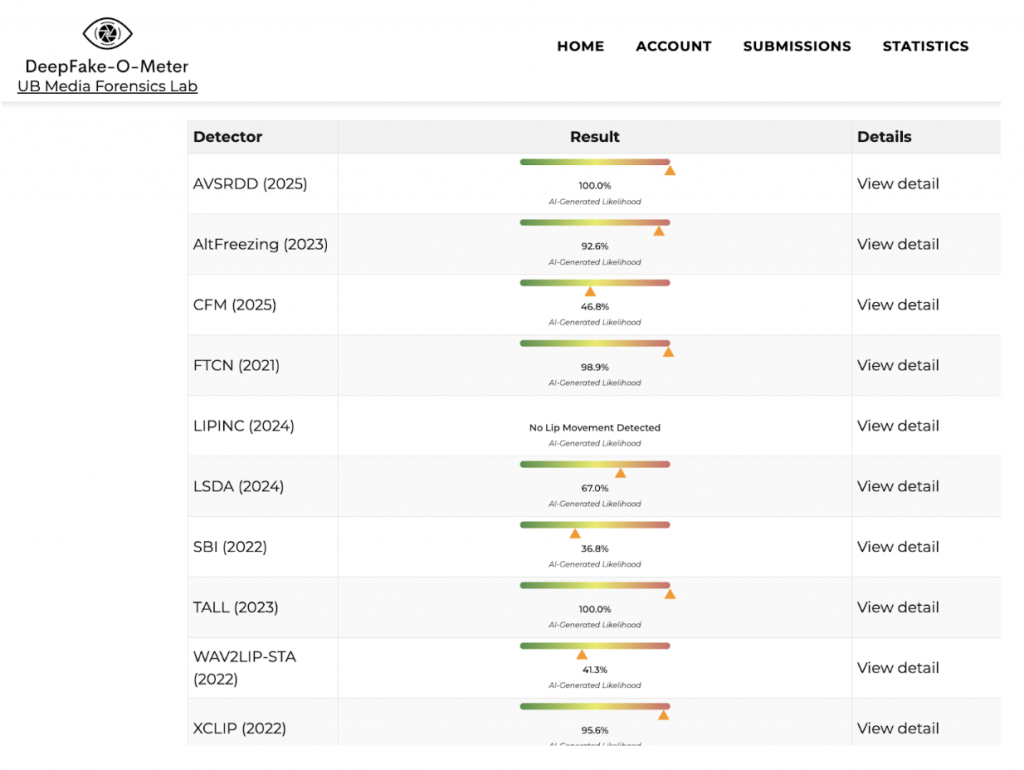

В социальных сетях, прежде всего в TikTok и Threads, активно распространяются видеоролики, на которых якобы украинские военные и ветераны войны приходят на заседание Верховной Рады Украины и эмоционально обвиняют народных депутатов в бездействии. В видео утверждается, что украинским солдатам «нечем воевать», что на позициях «осталось по три патрона», нет турникетов, дронов, тепловизоров и даже топлива. Эти заявления сопровождаются криками и агрессивной риторикой, создавая впечатление открытого конфликта между военными и властью.

На самом деле все эти видеоролики являются сфабрикованными и не имеют отношения к реальным событиям. Они были сгенерированы с использованием технологий искусственного интеллекта.

Это видно уже при внимательном визуальном анализе. Лица людей на видео выглядят размытыми и неестественными, мимика и движения – ограниченными и статичными. Люди на заднем плане часто сидят неподвижно, без естественных реакций, что нехарактерно для реальных видеозаписей в публичных местах. Элементы экипировки военных содержат многочисленные ошибки: на форме можно заметить несуществующие или искаженные нашивки, а государственный флаг Украины нередко имеет неправильные цвета или пропорции – например, сочетание желтого, синего и снова желтого цветов либо чрезмерно крупный, нереалистичный размер шеврона.

Нереалистично выглядит и сам зал заседаний: в отдельных роликах флаг Украины в помещении имеет неправильную цветовую схему, а архитектура и детали интерьера не соответствуют реальному залу Верховной Рады. Аналогичные визуальные ошибки присутствуют и в видео с якобы ветеранами: протезы изображены неправдоподобно, «сливаются» с одеждой или имеют формы, не соответствующие реальным медицинским изделиям.

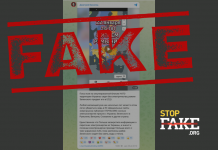

Для подтверждения выводов StopFake провел техническую проверку этих видеороликов с помощью инструмента DeepFake-O-Meter Лаборатории медиaфорензики Университета Баффало (UB Media Forensics Lab). Этот инструмент анализирует видео с использованием набора независимых алгоритмов, выявляющих признаки AI-генерации и цифровых манипуляций. Для надежности каждый ролик был проверен сразу несколькими детекторами.

Результаты анализа оказались схожими и однозначными. Большинство детекторов показали крайне высокую вероятность искусственного происхождения видео – от 90% до 100%. Такие значения характерны для синтетического или существенно модифицированного видеоконтента и не соответствуют параметрам аутентичных видеозаписей.

Особо показателен результат детектора LIPINC, который зафиксировал отсутствие естественного движения губ. Для реального видео с речью это нетипичная аномалия и, как правило, свидетельство использования технологий синтеза речи или наложения аудиодорожки, когда голос не синхронизирован с артикуляцией человека в кадре. Отдельные алгоритмы показали средние значения, однако это не меняет общего вывода: разные модели реагируют на разные типы артефактов, а в подобных случаях решающим является совокупный анализ, который указывает на использование искусственного интеллекта при создании или манипуляции видео.

Следует также обратить внимание на массовость и однотипность этих роликов. Они распространяются одновременно на разных платформах и повторяют один и тот же сюжет – «военные приходят в Верховную Раду на разборки». Это свидетельствует не о спонтанной реакции, а о целенаправленной информационной кампании.

Цель подобных вбросов – подорвать доверие между украинским обществом, вооруженными силами и властью, посеять раздор, усилить эмоциональное напряжение и спровоцировать агрессию, в том числе призывы к насилию в отношении представителей государственных институтов. Использование сгенерированных «эмоциональных» видео позволяет манипуляторам усиливать эффект воздействия, апеллируя к боли войны и реальным проблемам, но подменяя факты фальшивым контентом.

Ранее StopFake анализировал манипулятивные сообщения о том, что в январе украинцы якобы планировали «выйти на Майдан» против ТЦК.