1. Введение и ключевые выводы

Данный отчет обобщает результаты мониторинга, проведенного с 1 октября 2025 года по 31 декабря 2025 года в рамках проекта ATAFIMI, направленного на выявление и анализ случаев манипулирования информацией и вмешательства в информационное пространство (FIMI), происходящих из россии, в разных странах и на разных языках. Мониторинг охватывал следующие страны-участницы: Испания, Украина, Литва, Грузия, Босния и Герцеговина, Сербия, Аргентина, Колумбия, Мексика и Венесуэла.

Основные тезисы:

- Самым заметным дезинформационным нарративом в этот период были атаки на украинскую армию и иностранных военных, воюющих за Украину, — посты с ложными утверждениями собрали более 2 миллионов просмотров.

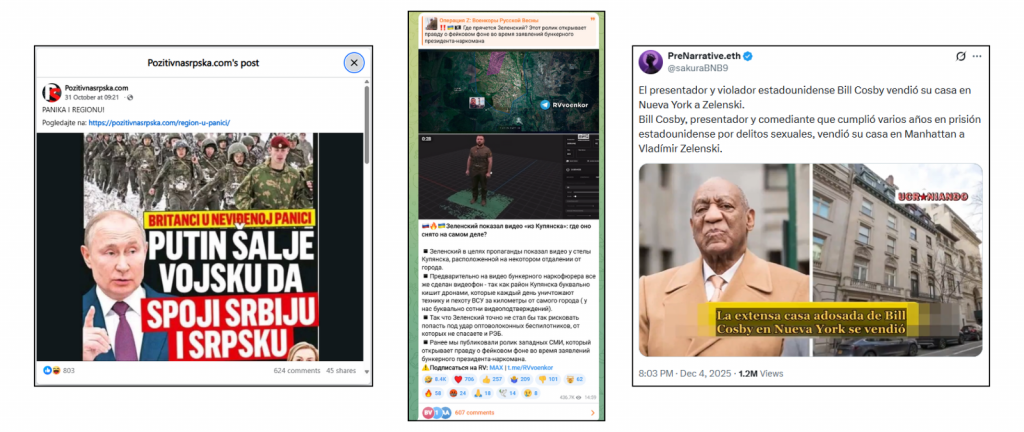

- Безосновательные обвинения в адрес Владимира Зеленского и коррупционные нарративы снова набрали обороты и были зафиксированы в 9 из 10 исследованных стран. Например, сообщения о якобы российском паспорте или покупке дома Билла Косби просмотрели более 3 и 1 млн раз соответственно.

- Широко использовался контент, созданный с помощью ИИ, для поддержки дезинформационных утверждений. Большинство вирусных постов получали опровержение от независимых фактчекеров в Facebook, иногда — предупреждение TikTok об AI-контенте. Зато у X появилась только одна Community Note, а у Telegram предупреждения вообще отсутствовали.

- Часть пользователей, распространявших дезинформацию в X, имела синие отметки — теперь они означают платную подписку и часто дают больше видимости контента.

- Трансграничные нарративы

Последний квартал 2025 года характеризовался использованием уже имеющихся нарративов, подкрепленных дезинформационными утверждениями, направленными против украинской власти, а также появлением новых нарративов, оказывавших большее влияние в странах Латинской Америки.

Новые нарративы

В период мониторинга появились заметные нарративы, сосредоточенные на теме рекрутинга в украинскую армию и человеческих потерь войны.

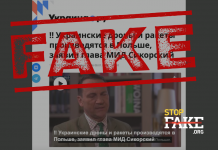

С одной стороны, распространяется дезинформация о мобилизации и призыве, а также о якобы массовых потерях Украины в составе Вооруженных сил. Эти нарративы усиливаются фейками о якобы похищении молодежи или пожилых людей, эмоциональными изображениями плачущих солдат, а также вымышленными внутренними конфликтами или актами насилия. Некоторые такие посты набирали более 3 миллионов просмотров.

Примеры дезинформационных утверждений, выявленных в пределах этих нарративов:

| Опровергнутое утверждение: | Утверждение распространялось в таких станах: |

| Украинский солдат записывает видео, на котором плачет после того, как его принудительно призвали на войну: «Я не хочу умирать» | Испания, Литва, Сербия, Венесуэла, Украина, Грузия, Мексика и Аргентина |

| Украина отправляет 17-летних защищать Покровск | Украина, Мексика и Испания |

| Украинские солдаты убили двух гражданских, которые несли белый флаг и собаку, при помощи дрона | Литва и Мексика |

Эти нарративы появляются вместе с еще одним направлением, непосредственно направленным против иностранных военных или потенциальных добровольцев, воюющих в составе украинской армии. Дезинформационные утверждения о якобы жестоком обращении с иностранными добровольцами широко распространялись как в Европе, так и в Латинской Америке с очевидной целью — сдержать новые вступления в ряды войск.

Данная тенденция дезинформационных нарративов была задокументирована в рамках совместного расследования, проведенного в рамках этого проекта. Особенно показательно, что часть такого контента целенаправленно фокусируется на добровольцах из Латинской Америки и активно распространяется именно в этом регионе.

| Опровергнутое утверждение: | Утверждение распространялось в таких станах: |

| Бразильский солдат, воюющий в Украине: «Ради Бога, я не должен был приезжать сюда» | Испания и Мексика |

| Сирийский наемник, которого увидели молящимся в украинском продуктовом магазине | Украина и Грузия |

| В результате российского нападения на аэродром в Староконстантинове «погиб американский военнослужащий» | Украина |

Кроме того, партнеры зафиксировали многократное использование медиа, созданных при помощи ИИ, для поддержки нарративов о человеческих потерях и якобы жестоком обращении. В частности, речь идет о видео с «военными», которые якобы заявляют о принудительной мобилизации или выражают сожаление из-за участия в войне.

Это важный аспект в контексте тактик, техник и процедур (TTP), которые были определены как ключевые инструменты для продвижения данных нарративов.

Повторяемые нарративы

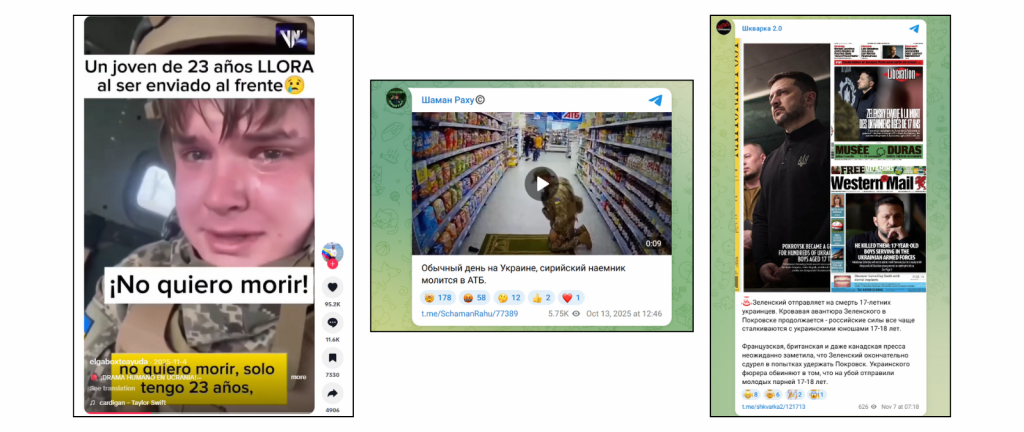

В этот период активно использовались уже существующие нарративы, направленные на подрыв доверия к Президенту Зеленскому и его лидерству, в частности, утверждение о якобы нецелевом использовании ресурсов военного времени и коррупции среди политических элит и органов власти. Их влияние, вероятно, сильнее в европейских странах, оказывающих Украине финансовую помощь.

Также в разных странах были зафиксированы новые утверждения наподобие уже выявленных ранее в рамках данного проекта. Например:

| Опровергнутое утверждение: | Утверждение распространялось в таких станах: |

| Зеленский ежемесячно переводит 50 млн долларов в банк в ОАЭ | Литва, Мексика, Испания, Венесуэла, Грузия, Украина |

| Зеленский купил ранчо стоимостью 79 млн долларов і стал одним из 10 самых богатых землевладельцев в Соединенных Штатах | Испания, Литва и Сербия |

| Елена Зеленская потратила более миллиона евро на дизайнерскую одежду, заявляем ее стилист | Украина, Литва и Грузия |

Тенденции по странам

Европа

Босния и Герцеговина

Часть выявленных дезинформационных утверждений была явно адаптирована под аудиторию Боснии и Герцеговины из-за использования местной истории, институтов и этнической чувствительности. Среди них — фейковые предупреждения о якобы планах Путина отправить войска для «объединения Сербии и Республики Сербской» (одной из двух политических составляющих Боснии и Герцеговины вместе с Федерацией Боснии и Герцеговины), а также утверждения, что Сербия и Хорватия являются «настоящими гарантами» Дейтонского мирного соглашения (1995).

Отдельно была адаптирована история, где якобы инциденты с дронами в Польше и Эстонии подавались как «операции под чужим флагом» — со сравнениями с манипулятивными утверждениями о трагедиях на рынке Маркале и улице Васе Мискина во время войны в Боснии 1990-х годов. Значительную часть такого контента публиковало российское государственное агентство Sputnik, достаточно сильно представленное в Боснии. имеющее сильное присутствие в Боснии. Наиболее вирусные дезинформационные материалы распространялись в Facebook и позже получали маркировку от независимых фактчекинговых организаций.

Сербия

Наиболее вирусные дезинформационные утверждения в регионе распространялись в Facebook и Instagram. Более 6600 пользователей одобрили пост с фейковой информацией о якобы захвате российскими военными офицеров НАТО (этот фейк был опровергнут фактчекерами в августе и получил маркировку на платформе).

Другие вирусные сообщения были направлены против Президента Зеленского — например, ложные утверждения о якобы его израильском паспорте, квартире в россии или ранчо в США, собравшие сотни лайков.

Видео, созданное с помощью ИИ, с «украинкой», которая якобы призывает продолжать войну, в то время как ее дети живут в Польше и Германии, набрало 98 000 просмотров. Это видео было также зафиксировано в Грузии.

Грузия

Вирусные посты в Facebook, просмотренные почти 2 миллиона раз, содержали созданные ИИ видео, где украинские военные, а также мужчины — сотрудники полиции и территориальных центров комплектования — изображались в провокативном контексте.

Этот контент соответствует тому же идентично ориентированному нарративу, что и другой опровергнутый фейк — когда грузино- и русскоязычные аккаунты в Facebook распространяли «опрос», якобы ставивший украинцев на первое место в мире по уровню гомосексуальности.

ИИ также использовали для создания фейкового контента в поддержку утверждений о якобы бегстве украинских командиров с поля боя.

Литва

В Facebook распространялся пост с более чем 980 реакциями и 189 репостами, в котором утверждалось, что «Литва запускает метеорологические шары над собственной территорией, чтобы ограничить транзит в Калининград». В то же время, национальные органы власти подтвердили, что эти шары попадают на территорию Литвы из Беларуси.

Другая конспирологическая теория, распространенная в Facebook (более 60 000 просмотров), пыталась убедить, что евреи якобы «взяли под контроль» правительство Президента Украины Владимира Зеленского с целью восстановления средневекового государства Хазарии.

Также в Facebook пост с 465 реакциями распространял фейковые утверждения о якобы использовании украинскими военными нацистской символики на форме — это один из нарративов, которые Россия продвигает в течение длительного времени.

Украина

Наиболее заметные дезинформационные материалы в Украине распространялись через Telegram. Прокремлевские каналы ставили под сомнение визит Президента Владимира Зеленского в Купянск (Харьковская область) 12 декабря 2025 года (более 430 000 просмотров), а также манипулировали темой его выступления на Генеральной ассамблее ООН в конце 2025 года, безосновательно заявляя о якобы цифровой манипуляции видео украинскимb вещателями. В целом, эти нарративы обвиняли Украину в информационных манипуляциях.

На той же платформе было обнаружено постановочное видео, где якобы украинские военные угрожают Эрике Кирк — вдове американского активиста Чарли Кирка после ее заявлений по Украине. Также широко распространялись дезинформационные утверждения о правовом статусе украинских беженцев.

Отдельно историческая пропаганда набрала более 11 000 просмотров в VK — самой популярной соцсети в России. В видео министр иностранных дел России Сергей Лавров заявлял, что Одессу и Николаев «создали русские люди», усиливая устоявшиеся исторические дезинформационные нарративы. Также утверждалось, что оба региона Украины якобы стремятся присоединиться к России.

Испания

В Испании наиболее вирусные дезинформационные посты распространялись через X, при этом только один из них был отмечен через Community Note. Два сообщения с фейковыми утверждениями о том, что Зеленский якобы купил таунхаус Билла Косби в Нью-Йорке за 29 млн долларов и ранчо на 79 млн долларов, вместе набрали около 2 миллионов просмотров.

Подобный уровень охвата имело видео, созданное с помощью ИИ (без маркировки), где якобы бразильский военный плачет и сожалеет о вступлении в украинскую армию.

Латинская Америка

Аргентина

В TikTok в Аргентине распространялось видео, созданное при помощи ИИ, которое набрало более 170 000 просмотров и утверждало, что война в Украине якобы завершилась, показывая празднование гражданских и военных. Очень похожее видео на украинском языке набрало 373 700 просмотров. Первое видео платформа автоматически обозначила как созданное ИИ, тогда как второе было отмечено самим пользователем.

Колумбия

Наиболее вирусный контент в регионе был сосредоточен вокруг нарратива о якобы большом количестве колумбийских наемников и добровольцев, воюющих в составе украинской армии. Разные дезинформационные утверждения строились вокруг этого нарратива и иногда совпадали с политическими месседжами и пророссийской риторикой — например, один из твитов на эту тему набрал более 153 000 просмотров.

Кроме того, видео, созданное с помощью генеративного ИИ (в том числе сервисов для создания гиперреалистичных видео и аудио), которое опубликовал уже удаленный TikTok-аккаунт «Ukraine is Death», показывало якобы захват колумбийских военных россией и набрало около 1,6 млн просмотров.

Отдельно очень вирусным стал пост от верифицированного фан-аккаунта, посвященного президенту Колумбии, где утверждалось, что Путин якобы поддерживает Колумбию и Венесуэлу и «остановит вторжение США в Карибском регионе». Этот пост собрал более 82 тысяч лайков и не был промодерирован платформой.

Мексика

Два видео TikTok с ИИ-контентом — одно с «украинским военным», плачущим после мобилизации, другое с «добровольцем», сожалеющим об участии в войне — превысили 3 млн просмотров без каких-либо предупреждений.

Еще два вирусных поста в Facebook продвигали нарративы о якобы массовой сдаче украинских военных, и только один из них имел отметку с опровержением.

У X также не было предупреждений возле дезинформационных утверждений о якобы российском паспорте Зеленского или о постановочных визитах в города, которые он якобы не посещал.

Венесуэла

Телеграм-канал Venezuela News, принадлежащий венесуэльскому веб-сайту, регулярно распространяющему пророссийскую дезинформацию и имеющему более 56 000 подписчиков, опубликовал статью, в которой утверждалось, что 23-летний украинский солдат плакал после принудительного призыва. Эта же статья была опубликована на X несколькими аккаунтами с синей отметкой X Premium и распространялась в разных странах.

Информация о проекте

Этот отчет является частью проекта ATAFIMI. Благодаря созданию инновационного технологического инструмента для исследования FIMI (иностранного манипулирования информацией и вмешательства) и трансграничных кампаний дезинформации, система централизует и работает как хранилище контента с дезинформацией, выявленного в странах-участницах. Использование общей методологии позволяет выявлять трансграничные дезинформационные кампании, а также нарративы, одновременно распространяющиеся в Европе и Латинской Америке.

Проект направлен на выявление и анализ случаев информационных манипуляций и вмешательства, происходящих, в частности, из России, в разных странах и языковой среде.

Фактически он работает как централизованная система сбора и анализа дезинформации: партнеры передают обнаруженный контент в общее хранилище, что позволяет отслеживать, как одна и та же дезинформация распространяется между странами.

В проект входят следующие организации:

Fundación Maldita.es (Испания), StopFake (Украина), Delfi (Литва), Myth Detector (Грузия), Zašto ne (Боснія и Герцеговина), RasKRIKavanje и FakeNews Tragač (Сербия), Chequeado (Аргентина), La Silla Vacía (Колумбия), Verificado.mx (Мексика) та Cazadores de Fake News (Венесуэла).