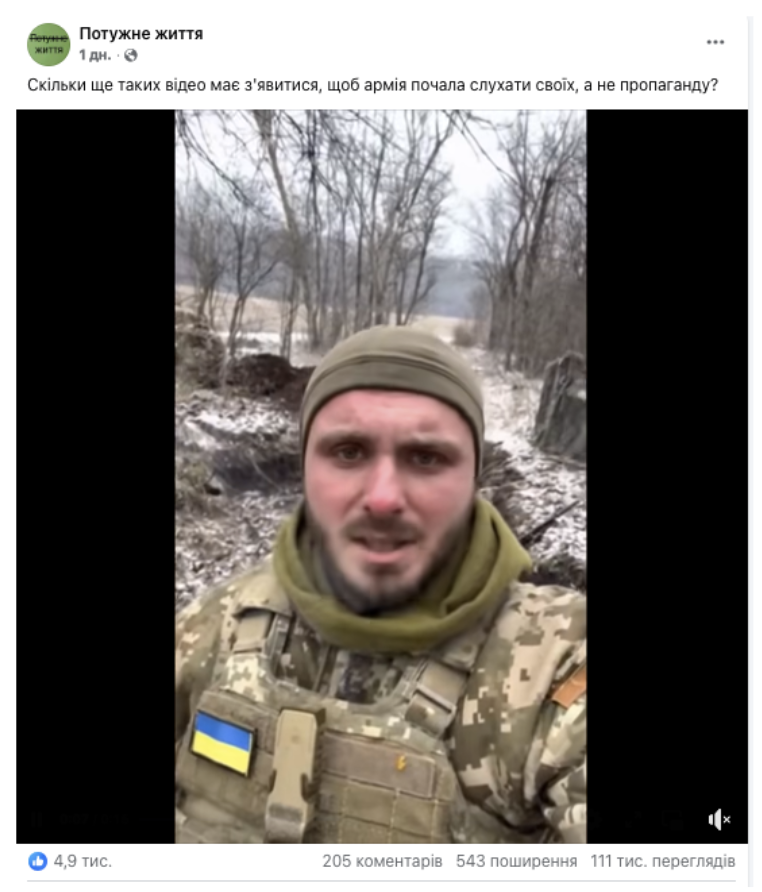

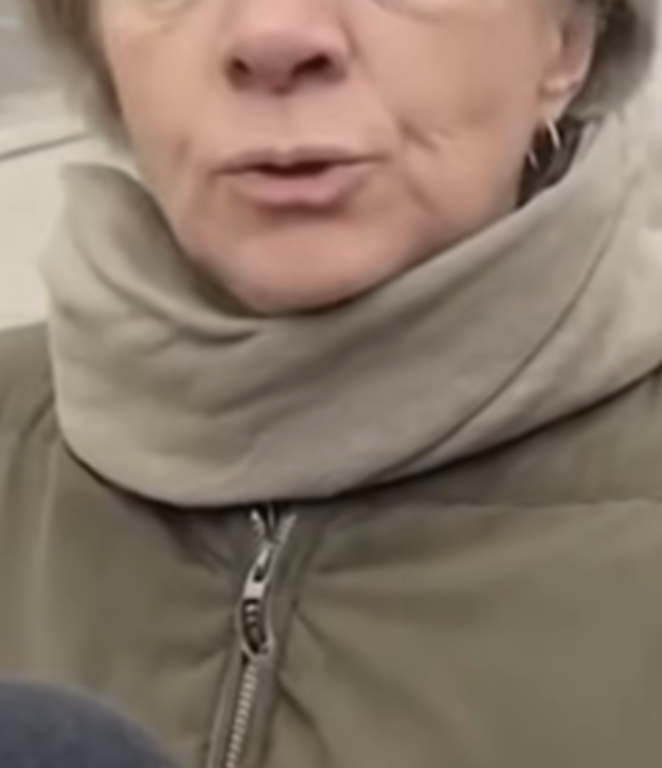

Все видео, распространяемые на странице «Потужне життя», были сгенерированы с помощью нейросети.

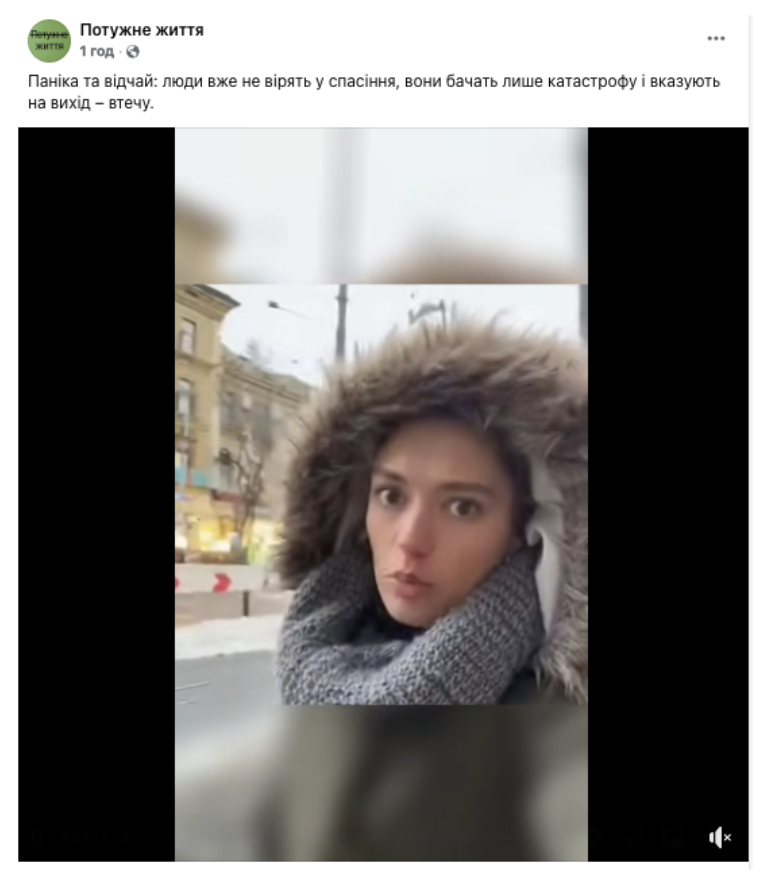

На Facebook набирает популярность страница «Потужне життя» (рус. – «Мощная жизнь»), публикующая короткие ролики якобы уличных интервью и видеообращений украинских граждан. Каждый из роликов собирает десятки тысяч просмотров, сотни распространений и комментариев как критических, так и одобрительных. Среди видео — обращения якобы военных, которые вроде бы советуют собратьям складывать оружие и сдаваться; женщина, призывающая Зеленского уйти с должности и называющая легитимным президентом Януковича; девушка, которая рассказывает о неизвестном селе, в котором якобы еще в первые дни войны мобилизовали всех мужчин и ни один из которых не выжил. «Это не война, это финансовая операция», «наши враги сидят не в окопах, а в креслах», «мы погибаем за чью-то зарубежную недвижимость» – вот еще несколько цитат из видео, которые страница распространяет много раз в день.

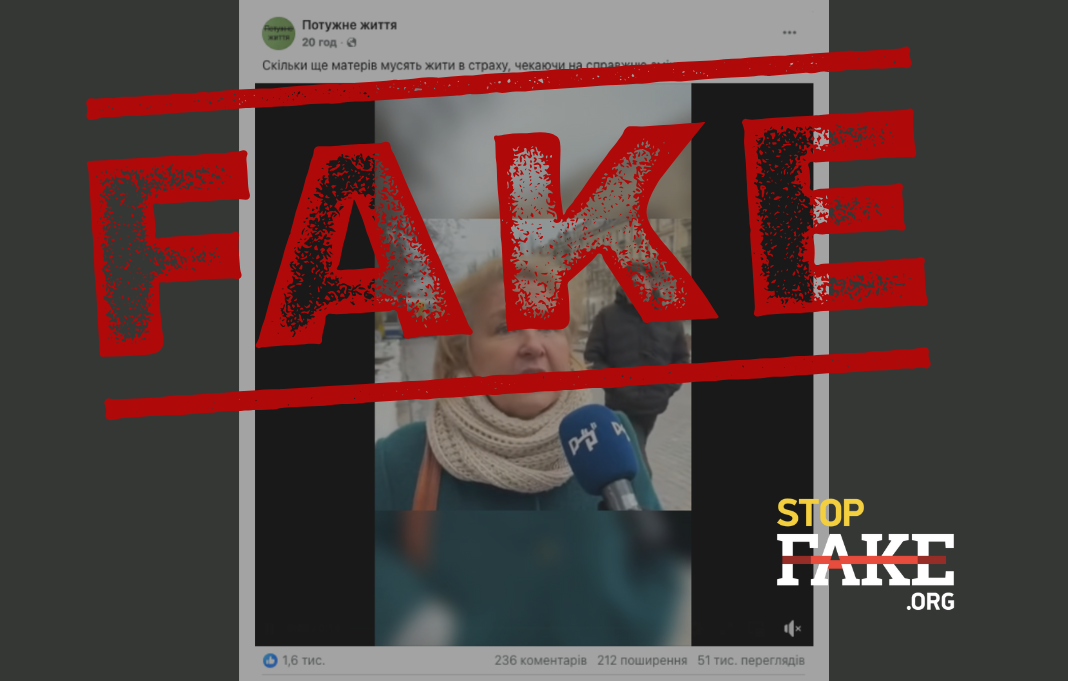

Однако все ролики, распространяемые на странице «Потужне життя», были сгенерированы с помощью ИИ. Об этом свидетельствует и стиль речи героев роликов — все они, хоть и представлены как случайные прохожие, говорят как бы заученными словами и слоганами, используя слова типа «классовая война» и «ликвидность», — так и многочисленные визуальные неточности. Например, на видео, где журналистка якобы показывает военное кладбище, показана могила, на которой написано только имя «Сергий» без фамилии и через букву «и». В ролике, где у женщины якобы берут интервью на улице, логотип канала на микрофоне не похож ни на одну настоящую систему письма. На другом же видео неестественный вид имеет застежка на куртке.

Такой контент называется «AI-slop», то есть ШИ-помои или шлак — низкокачественный цифровой контент, который генерируется с помощью нейросети и массово распространяется в интернете. Под эту категорию попадают и видео с танцующими котами, и подобная примитивная пропаганда, которая, впрочем, оказывается очень действенной. О подобных кейсах уже писали наши коллеги из «Текстов»: одна из предыдущих дезинформационных кампаний, сделанных таким образом, была посвящена вымышленному государственному перевороту в Украине. С контентом «Потужного життя» у этих кампаний много общего, в частности, акцент на сильных эмоциях и острых, противоречивых темах, таких как коррупция и мобилизация.

«Слопаганда отличается от традиционной пропаганды масштабом, объемом и скоростью. GenAI быстро и дешево создает большие объемы сфабрикованного контента, что делает его более доступным. Он генерирует высоко персонализированный и разнообразный контент, следовательно, может привлекать людей в больших масштабах», — объясняет философ Марк Альфано. Несмотря на то, что значительный процент взаимодействий с подобным контентом – это боты, многие реальные люди также воспринимают ролики некритически. В комментариях пользователи спорят или соглашаются со сказанным. Даже распознав ИИ, некоторые утверждают, что формат материала неважен, главное — суть сказанного. Любые интеракции с сообщениями – а особенно отрицательные – только продвигают публикации в алгоритмах и показывают их еще большему количеству пользователей.

По словам специалистов, опасность таких «ИИ-помоев» заключается в том, что затем нейросети будут учиться на этом контенте и начнут генерировать новые материалы на его основе, таким образом, только усиливая пропагандистские нарративы. Так, уже сейчас популярные ИИ-чатботы, отвечая на вопрос о российском вторжении в Украину, активно ссылаются на подсанкционные российские государственные ресурсы — рупоры кремлевской пропаганды, что создает огромное пространство для манипуляции информацией.

Разбор еще одной дезинформационной кампании, реализуемой с помощью низкокачественного ИИ, читайте в материале Видеофейк: Военные «пришли на разборки» в Верховную Раду.