Найімовірніше, відеоролик з «волонтером», що поширюється в мережі, — підробка, створена за допомогою штучного інтелекту. Перевірка з використанням інструментів DeepFake-o-meter, Attestiv і Video AI Detector показала високу ймовірність того, що зображення та звук синтетичні. Відео містить типові ознаки deepfake – неприродні рухи губ і очей, розмиті риси обличчя та несинхронність мови.

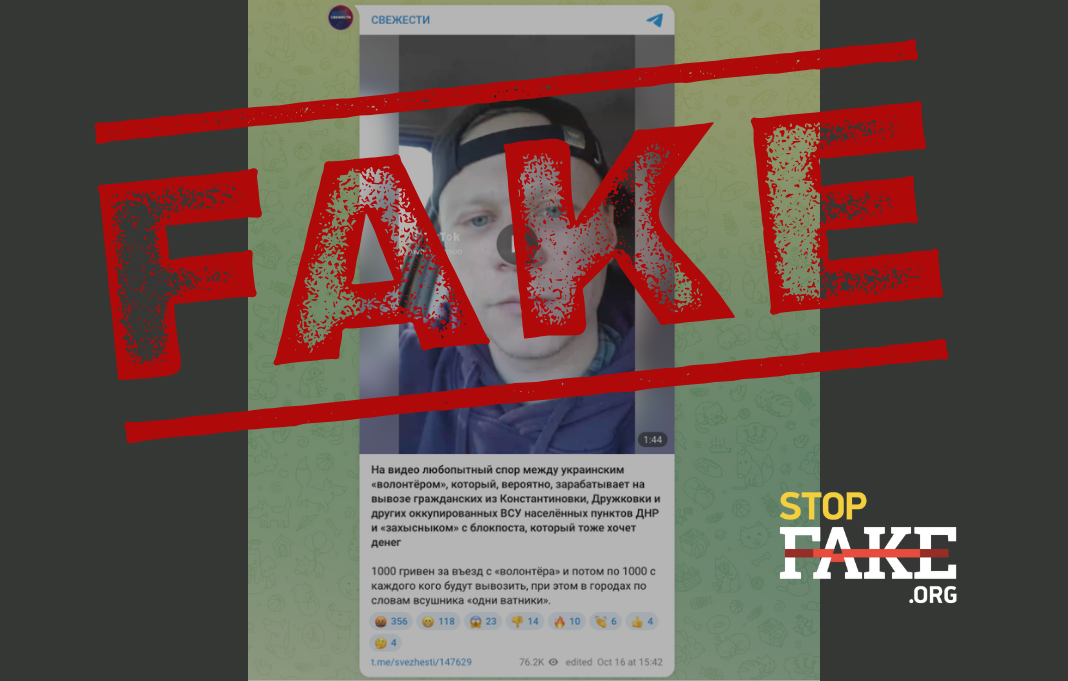

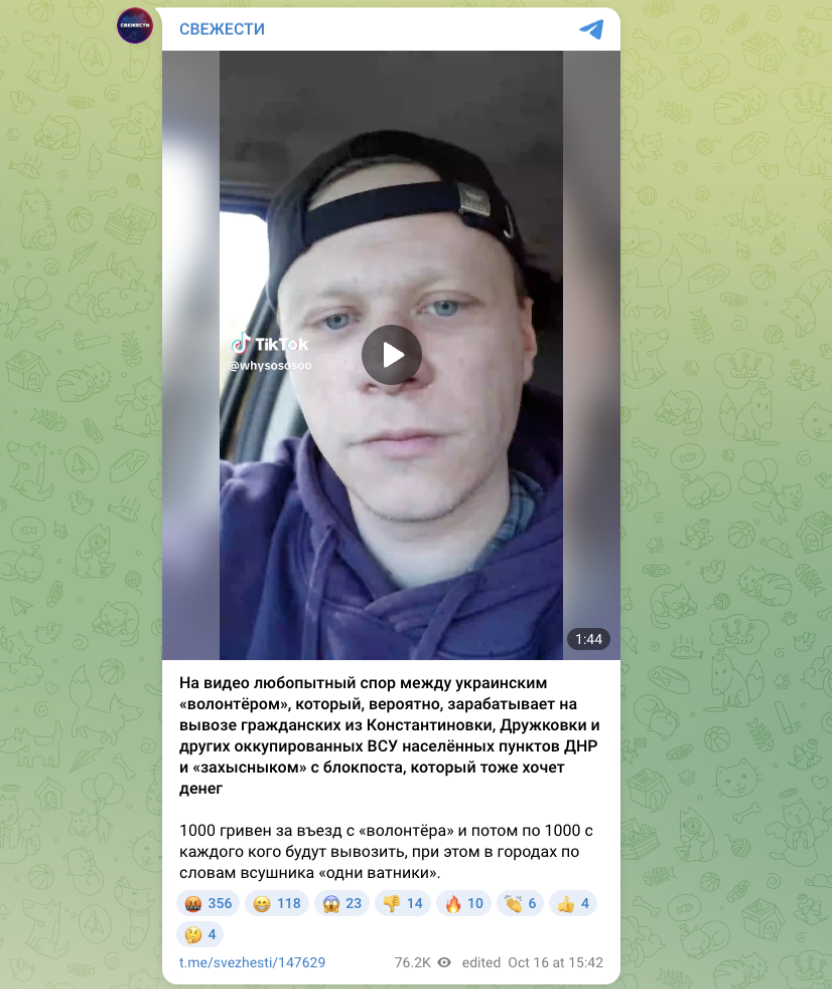

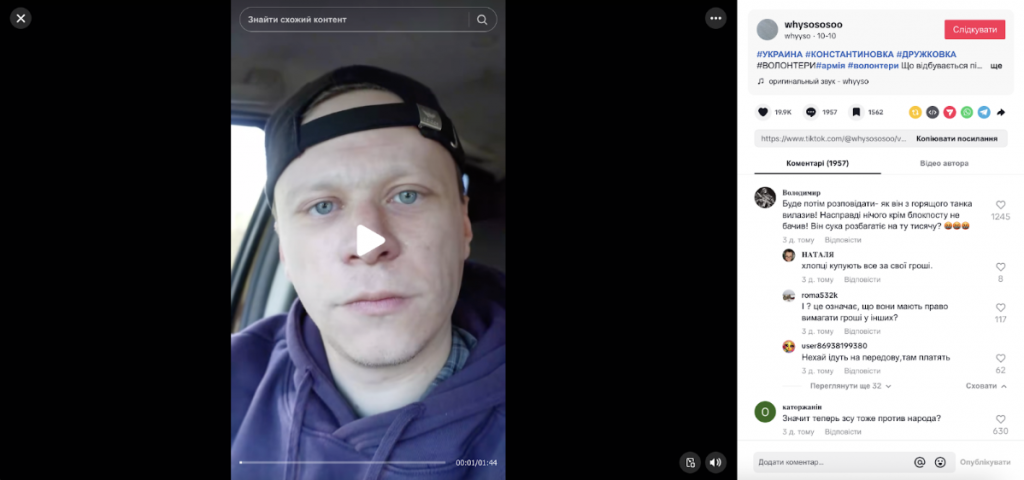

Користувачі мережі поширюють відеоролик нібито волонтера, який стверджує, що українські військові беруть по 1000 гривень із кожної людини за в’їзд і виїзд із прифронтових міст. У другій частині відео показано нібито кадри, зняті прихованою камерою, де «військовий» вимагає гроші з «волонтера» за вивіз із міста «ватників» і каже, що ці кошти потрібні йому на паливо та одяг.

Відеоролик складається із двох частин. У першій чоловік, який назвався волонтером, розповідає, що на одному з блокпостів у нього нібито вимагали 1000 гривень за в’їзд до міста, а потім ще по 1000 гривень за кожну вивезену людину. У другій частині показано «розмову» з нібито українським військовим, який вимагає гроші й заявляє, що всі цивільні, що залишилися в місті, – «сепари».

Описана ситуація, швидше за все, вигадана, а сам відеоролик, мабуть, створений у пропагандистських цілях.

Першим це відео опублікував анонімний профіль TikTok – @whysososoo 10 жовтня. Його водяний знак можна побачити на всіх поширених копіях ролика. Показово, що відео з «волонтером» – єдина оригінальна публікація цього акаунту. Решта записів – це репости танцювальних роликів. У профілі немає ані імені, ані контактної інформації, ані ознак того, що сторінку веде людина, яка займається волонтерською діяльністю. На сьогодні відео набрало близько 20 тисяч лайків і 2 тисяч коментарів.

Також показово, що цей відеоролик поширюють виключно прокремлівські Telegram-канали. За даними сервісу Osavul, вперше в Telegram його опублікував канал “Свежести” 16 жовтня, після чого ролик почав активно тиражуватися в мережі.

StopFake не вдалося встановити особу чоловіка, зображеного на відео. Проте ретельний аналіз свідчить про те, що ролик створено з використанням штучного інтелекту.

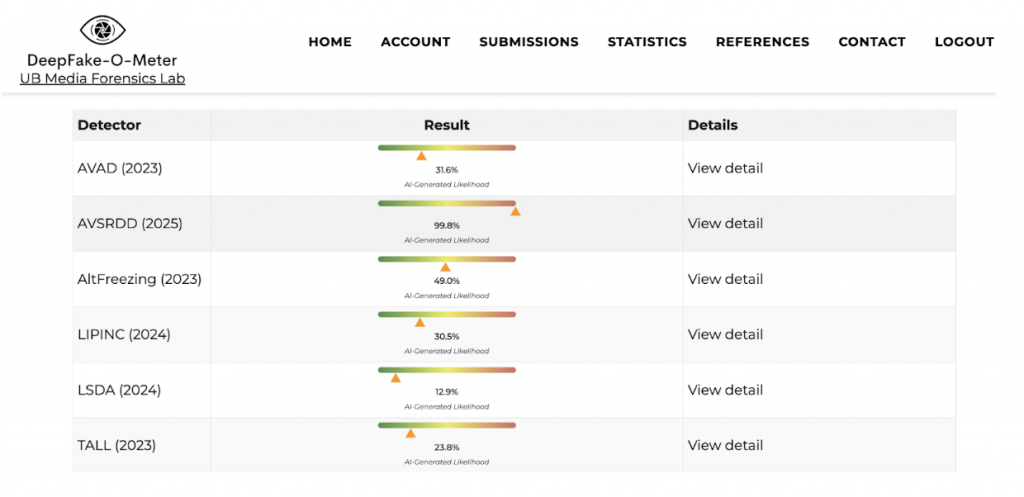

StopFake перевірив відео за допомогою інструменту DeepFake-o-meter (Університет Буффало), який аналізує фото, відео та аудіо на предмет маніпуляцій із застосуванням ШІ. Для надійності ролик було протестовано кількома різними алгоритмами.

Результати аналізу показали, що відео з високою ймовірністю є штучно згенерованим. Один із детекторів – AVSRDD, що спеціалізується на аналізі синхронізації звуку та зображення, – продемонстрував майже 100% впевненість у тому, що це deepfake. Інші моделі показали від низьких (10-31%) до середніх (49%) показників ймовірності підробки. Ще один алгоритм зафіксував невідповідність рухів губ мовленню, що також свідчить про штучне походження відео.

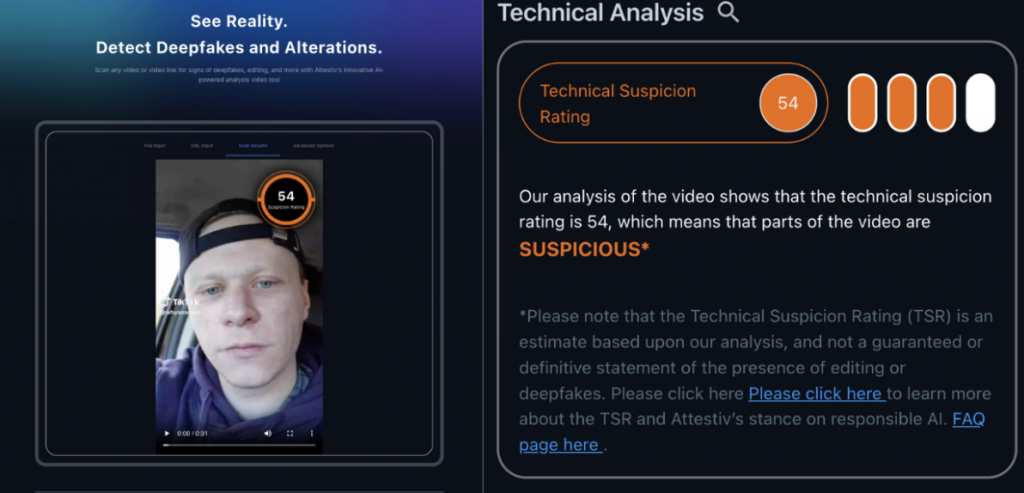

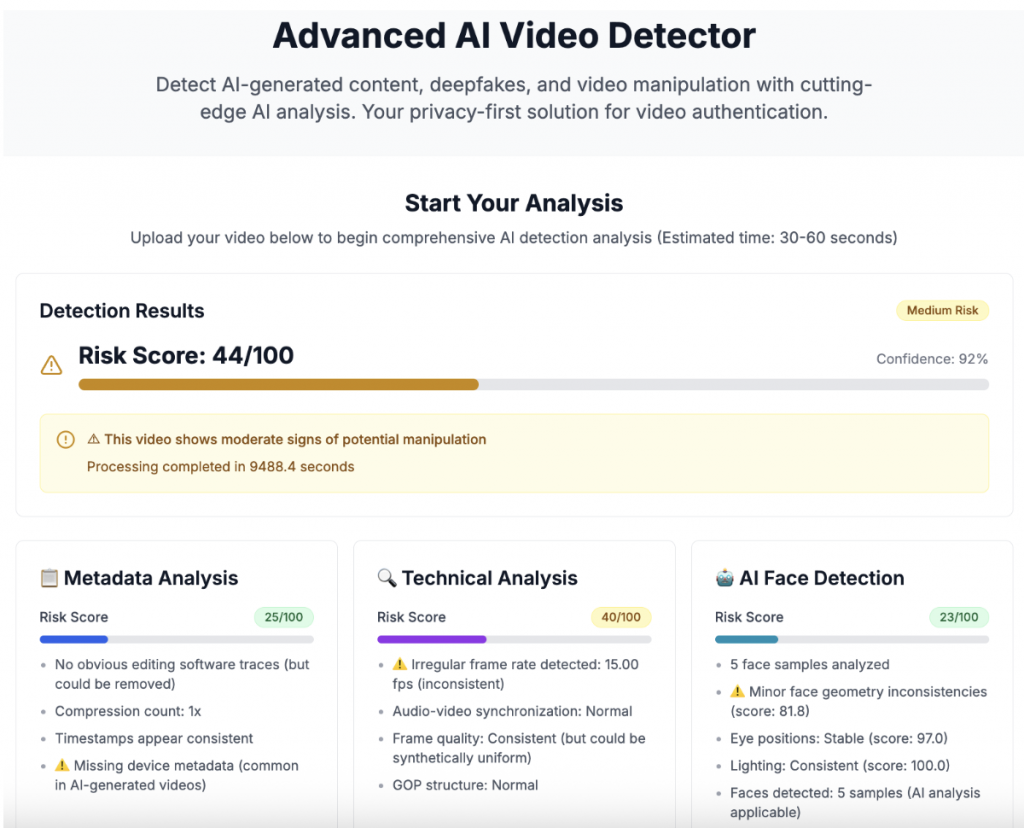

Інші сервіси, такі як Attestiv і Video AI Video Detector, також показали високі показники підозрілості – 54 і 44 бали відповідно. Це означає, що окремі частини відео, найімовірніше, були створені за допомогою нейромереж.

Навіть без інструментального аналізу можна побачити неприродні рухи губ і очей, і навіть розмиті риси обличчя – характерні ознаки синтетичного зображення.

Друга частина ролика, де «волонтер» нібито потай записує розмову з військовим, також справляє враження постановочної. На це вказують театральність поведінки учасників, неприродна інтонація та акцент, що дає змогу припустити, що українська мова для них не є рідною. Крім того, «волонтер», що сидить за кермом автомобіля, в якийсь момент говорить комусь «розвертайся», що нелогічно, адже він сам керує машиною. На відео не видно обличчя співрозмовників, а також сам блокпост, що унеможливлює ідентифікацію учасників ситуації та обставин.

StopFake не вдалося знайти жодного доказу того, що українські військові справді вимагали гроші з цивільних осіб чи волонтерів на блокпостах. Евакуація зі згаданих у публікаціях міст – Дружківки та Костянтинівки – здійснюється безкоштовно силами місцевої влади та Державної служби України з надзвичайних ситуацій.

Отже, ніяких підтверджень автентичності описаної історії немає.

Такі ролики створюються для дискредитації українських військових і волонтерів, а також для підриву довіри до української держави. Під виглядом «викриттів» такі відео формують уявлення про корупцію, хаос та моральний занепад в українському суспільстві, посилюючи втому та розчарування аудиторії. Їхня кінцева мета – ослабити підтримку України як усередині країни, так і за її межами.

Раніше StopFake аналізував створений за допомогою нейромережі фейковий відеоролик про нібито мобілізацію людей із синдромом Дауна до ЗСУ.