Piotr Mateusz Bobołowicz

Walka z dezinformacją pod koniec czwartego roku pełnoskalowej rosyjskiej agresji na Ukrainę ma charakter globalnego wysiłku, który często może sprawiać wrażenie bezcelowego. Nowe technologie pozwalają na niskokosztowe i wysokoefektywne produkowanie treści dezinformacyjnych, co Rosja ochoczo wykorzystuje. Jednocześnie modele AI, mimo że same w sobie obarczone błędami i podatnością na dezinformacje dają nowe metody weryfikacji faktów i tworzenia rzetelnych treści. Niniejszy artykuł jest próbą zarysowania sytuacji i odpowiedzi na pytanie, o efektywność i sens dalszej walki z dezinformacją w dotychczasowej formie.

Według danych przedstawionych przez firmę Imperva w 2024 roku ruch internetowy generowany przez boty przekroczył po raz pierwszy 50%.[1] W Internecie oficjalnie jest już więcej zautomatyzowanych botów niż ludzi. Warto zaznaczyć, że tylko 17% generują dobre boty – czyli te pozycjonujące strony, pomagające uczyć się LLM (Wielkim Modelom Językowym – czyli popularnym czatom AI) i pełniące inne pożyteczne funkcje w Internecie. Aż 37% ruchu to złe boty, które przeprowadzają ataki cybernetyczne, wyłudzają i kradną dane – czy też rozpowszechniają dezinformację i hejt albo po prostu generują spam. Wchodząc na portale społecznościowe można dojść czasem do wniosku, że tzw. „teoria martwego internetu”[2], która głosi, że większość treści generowana jest przez boty i algorytmy dla innych botów i algorytmów, chociaż może nie jest w stu procentach prawdziwa, to jednak dobrze pokazuje istniejące tendencje. Wciąż jednak na końcu tej układanki stoi człowiek, często przeciwstawiony korporacjom albo innym podmiotom instytucjonalnym, które dysponują zasobami pozwalającymi na automatyzację procesów zachodzących w sieci.

Nawet te dobre boty mogą mieć negatywny wpływ na pewne aspekty funkcjonowania online. Przykładowo generują one pozorny ruch na stronach internetowych, zafałszowując wyniki kampanii marketingowych i doprowadzając do niewłaściwego wydatkowania przeznaczonego na nie budżetu. Szczególnie ważna w tym kontekście staje się także pułapka uczenia się LLM, które znajdując coraz więcej treści generowanych przez sztuczną inteligencję degenerują się w kolejnych iteracjach efektywnie obniżając jakość generowanej odpowiedzi[3].

Widać jasno płynące z tego zagrożenie w kontekście dezinformacji – zautomatyzowane zalewanie Internetu treściami o charakterze dezinformacyjnym (tzw. flooding-the-zone – dosłownie zalewanie strefy – nawiązanie do taktyki informacyjnej Steve’a Bannona, byłego stratega politycznego Donalda Trumpa[4]) prowadzi do trenowania na nich modeli AI, które potem z większym prawdopodobieństwem podają zafałszowane odpowiedzi. Mimo obecności w tych procesach tzw. human-in-the-loop, czyli ręcznego ludzkiego sterowania procesem treningu, nie da się tego wyeliminować ze względu na skalę danych, które analizują modele językowe każdego dnia.

Ale zautomatyzowana dezinformacja zatruwa nie tylko czaty AI, ale także ludzkie umysły i, być może przede wszystkim, emocje. Jest taki szmonces, w którym po kolacji ze znajomymi gospodarzom ginie srebrna łyżeczka. W rozmowie telefonicznej gość przekonuje oczywiście, że nie ma z tym nic wspólnego, a na koniec gospodarz mówi w końcu, że „łyżeczka się znalazła, ale niesmak pozostał”. Konfrontacja z nieprawdziwością danej informacji, zakładając optymistyczny scenariusz, że do takiej konfrontacji w ogóle dochodzi, nie zmienia faktu, że emocje, które wywołała pierwotna (dez)informacja zostały już wywołane i odcisnęły piętno na użytkowniku. Nasila się to szczególnie w obecnej sytuacji, gdy użytkownicy mediów społecznościowych rzadko czytają treści artykułów, opierając się tylko na nagłówkach[5].

Analiza nagłówków prasowych w Internecie w latach 2000-2025, której dokonali Pietro Nickl Mehdi Moussaïd i Philipp Lorenz-Spreen pokazuje, że media przesunęły się drastycznie w stronę sensacjonalizmu i negatywnego przekazu[6]. Nagłówki nie pełnią już tylko funkcji informacyjnej, ale mają za zadanie wywołać silną reakcję emocjonalną. Odnotowano wzrost negatywnie nacechowanego przekazu aż o 30%. Nagłówki stały się średnio o 25% dłuższe. Ewolucja przebiegła od krótkich równoważników zdań (styl telegraficzny, np. z roku 2000) do pełnych, rozbudowanych zdań. Równocześnie użycie zaimków osobowych (np. „ty”, „twoje”) wzrosło o 20%, co ma na celu skrócenie dystansu i bezpośrednie zaangażowanie czytelnika. Podobny cel mają nagłówki w formie pytań – ich liczba wzrosła o 15%. Wszystkie te cechy potęgują reakcję emocjonalną na wyświetlane (bo ciężko powiedzieć, że czytane) treści. Co gorsza również uznawane dotychczas za rzetelne media uciekają się do podobnych technik ze względu na konieczność konkurowania na wysoce kompetytywnym rynku mediów internetowych. Nadawanie nagłówkom formy pytań pozwala także na sprytne przemycanie kontrowersji, które w łatwy sposób zakłamuje rzeczywistość – czasami celowo, chociaż często jedynie przypadkiem. Zarzucenie komuś korupcji lub innego skandalu i postawienie na końcu znaku zapytania chroni autora tekstu – przecież w samym artykule wyjaśnione jest, że mimo podejrzeń jednak tak nie było – ale u odbiorcy, który nie analizuje treści prowadzi to do utrwalenia negatywnych skojarzeń wobec jakiejś osoby, państwa czy grupy. Media często cytują dosłownie oświadczenia rosyjskich oficjeli, bez weryfikacji faktów, natomiast tytuły wprost powielają tezy rosyjskiej propagandy – mimo że w treści artykułów jest ona potem tłumaczona.[7]

Tym bardziej niepokojący jest fakt, że użytkownicy mediów społecznościowych nie tylko artykułów nie czytają, ale udostępniają te treści bez ich uprzedniej lektury. Według badania przeprowadzonego w latach 2017-2020 przez S. Shyama Sundara i Jamesa P. Jimirro opublikowanego w Nature Human Behavior dotyczy to aż 75% udostępnień.[8] Tylko jedna czwarta linków powielana jest w sposób świadomy. Badanie ukazało się dopiero w 2024 roku, ale można mieć uzasadnione obawy, że w międzyczasie sytuacja nie uległa polepszeniu, a wręcz przeciwnie. Problemem, który nie istniał w tamtym czasie, a z którym mierzymy się dzisiaj, jest zwielokrotnienie oddziaływania niesprawdzonych informacji przez wspomniane wcześniej zjawisko zatruwania modeli językowych.

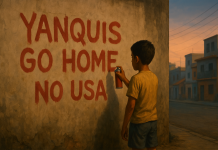

Według badania przeprowadzonego przez Uniwersytet w Melbourne i KPMG aż 58% użytkowników na świecie postrzega AI jako godne zaufania.[9] Jednocześnie warto zwrócić uwagę na różnice wyników między państwami – z jednej strony spektrum są kraje wysokorozwinięte takie jak Finlandia, kanada, Nowa Zelandia czy Francja, w których zaufanie to kształtuje się poniżej 50%. W okolicach 50% znajdują się między innymi Stany Zjednoczone czy Wielka Brytania. Warto zwrócić uwagę na Polskę – tutaj ok. 56% użytkowników ufa AI. Na drugim końcu spektrum są kraje globalnego południa – Chiny, Indie, Egipt czy Nigeria, gdzie zaufanie to sięga do ponad 80%. Widać tu pewną korelację z działaniami dezinformacyjnymi Federacji Rosyjskiej. Tam, gdzie wyższe jest zaufanie do AI, szczególnie dobry grunt znajdują narracje propagandowe Kremla. Może mieć to związek z wieloma czynnikami – jednym z nich z pewnością jest niska ogólna umiejętność korzystania z mediów i informacji oraz usług cyfrowych (ang. media literacy i digital literacy), wiążąca się również ze średnim poziomem wykształcenia. Gdy weźmiemy pod uwagę liczbę ludności tych państw, to maluje nam się zatrważający obraz świata, w którym treści dezinformacyjne mają doskonały grunt do rozwoju. W zestawieniu z atrakcyjnością pewnych rosyjskich narracji propagandowych w tych państwach (szeroko pojęte budowanie alternatywy wobec Zachodu i „zachodniego imperializmu”, antykolonializm) oraz z ich współpracą z Rosją na płaszczyźnie oficjalnej w ramach BRICS+ tworzy to potężny rozsadnik treści wpisujących się w rosyjską propagandę.

Warto tutaj też wspomnieć o fenomenie rosyjskich mediów państwowych w Ameryce Łacińskiej. Hiszpańskojęzyczne wydanie telewizji znanej wcześniej jako Russia Today, dzisiaj maskująca się pod akronimem RT en Español posiada więcej obserwujących na Facebooku niż jakikolwiek inny międzynarodowy nadawca hiszpańskojęzyczny (np. BBC Mundo, Deutsche Welle czy nawet El País)[10]. Na TikToku zgromadziło ponad 29,6 miliona „polubień”, triumfuje także – w postaci rozmaitych klonów – na YouTube, mimo bana na rosyjskie media państwowe.

Przed kilkoma laty głośno było o kupowaniu „like’ów” w mediach społecznościowych[11]. Korzystali z tego influencerzy, ale także powstawały praktycznie całkiem sztuczne konta. Przy odpowiednim nakładzie finansowym można stworzyć i uwiarygodnić profile. Liczba obserwujących czy aktywność pod postami ma podwójne znaczenie – z jednej strony podbija widoczność danych treści dla algorytmów, co przekłada się na zwiększone oddziaływanie na realnych odbiorców, a z drugiej wzmacnia zaufanie do takich treści – przecież skoro tyle osób to obserwuje czy „like’uje”, to musi to być prawda. Wiele z tego typu kont to boty, ale operatorzy mediów społecznościowych starają się je zwalczać. Z drugiej strony w roli „botów” nierzadko występują mieszkańcy globalnego południa – szczególnie Azji Południowo-Wschodniej, Indii czy Pakistanu, gdzie bardzo drobne pieniądze, które można zarobić na tym procederze mają większe znaczenie.

W listopadzie 2025 roku portal X (dawny Twitter) wprowadził nową funkcjonalność, pokazującą w sposób niemodyfikowalny dla użytkownika skąd konto zostało założone i skąd publikowane są treści. Ujawniło to, że wiele aktywnych kont wpisujących się w rosyjskie narracje dezinformacyjne występujących jako konta z USA czy Unii Europejskiej pochodzi albo z wspomnianych wyżej rejonów świata, albo wprost z Rosji i Białorusi, albo z Holandii, ale przy używaniu VPN – Holandia oferuje dobrą jakość usług w tym zakresie, jednocześnie dając wygodną przykrywkę „europejskości” takim użytkownikom.

Platforma X jest też ciekawym przypadkiem prób samoregulacji branży mediów społecznościowych. Pierwsze próby podejmowane były jeszcze przed pandemią Covid-19, ale to właśnie propaganda antyszczepionkowa i prawdziwa epidemia dezinformacji w tamtym okresie pokazała powagę sytuacji, doprowadzają w 2022 roku do wprowadzenia Kodeksu Postępowania wobec Dezinformacji w Unii Europejskiej[12]. Wielu dostawców podjęło różne działania, także z różnym skutkiem, natomiast platforma Elona Muska (przejęta przez niego w październiku 2022) postawiła na „uwagi społeczności” (ang. community notes), czyli oddolny factchecking oparty na zaangażowaniu samych użytkowników. Decentralizacja tego procesu z pewnością przekłada się na skalę odpowiedzi, jednak jej szybkość nie jest wystarczająca i pomija najbardziej viralowy moment udostępniania dezinformacyjnych treści[13]. Ogółem uwagi społeczności zmniejszają zasięg ostateczne oddziaływanie dezinformacji zaledwie o kilkanaście procent (mimo że oflagowane posty udostępniane są praktycznie połowę rzadziej). Mimo że jest to wymierny rezultat, to w zalewie treści o charakterze dezinformacyjnym jest to zdecydowanie niewystarczające.

Jest to ogólny trend w factcheckingu. Podczas gdy dezinformacja osiąga bardzo szybko viralowe zasięgi, treści obalające dezinformację lub ją uprzedzające mają finalnie w wyniku kaskadowych procesów rozpowszechniania treści w mediach społecznościowych zasięgi 10-20 razy niższe[14]. Pocieszający jest jednak fakt, że dezinformacja, mimo potężnych zasięgów, trafia często na niepodatny grunt. Rzetelne informacje mają większe oddziaływanie na grupę odbiorców, mimo że ogólnie ich zasięgi są niższe. Jednocześnie istnieje grupa użytkowników o radykalnych poglądach, która szerzy treści dezinformacyjne[15]. Tyle wynika z badań. Faktem jednak jest, że w wielu państwach Zachodu środowiska polityczne rozprzestrzeniające dezinformacje zwiększają swoje poparcie polityczne i obecność medialną. Dobrym przykładem jest tu niemiecka scena medialna, gdzie badania pokazały, że w przebadanej próbce 1382 odcinków programów informacyjnych i talk-show z lat 2023-2024 aż w 4,85% pojawiły się treści dezinformacyjne, z czego wskaźnik dla talk-show wyniósł aż 11,62%[16]. Większość dezinformacji w mediach pochodzi od populistycznych polityków (głównie AfD), a dziennikarze tylko w połowie przypadków zadają sobie trud korygowania fałszywych twierdzeń. Podobne trendy widać w Polskich mediach. Połączone jest to także z celowym zapraszaniem kontrowersyjnych polityków będących wektorami dezinformacji zbieżnej z rosyjskimi narracjami propagandowymi w celu zwiększania zasięgów poprzez kontrowersje.

W Polsce oddziaływanie dezinformacji na społeczeństwo widać na przykładzie zmiany stosunku do innych narodów. Po rosyjskiej pełnoskalowej agresji na Ukrainę w 2022 roku sympatia do Ukraińców (51% respondentów) i niechęć do Rosjan (82% respondentów zadeklarowało niechęć) były rekordowo wysokie. W badaniu CBOS z poicząktu 2025 roku widać jednak zmianę tych trendów. Sympatię do Ukraińców deklaruje już tylko 30% respondentów, natomiast niechęć do Rosjan spadła o 10 punktów procentowych – do 72% i tak pozostając rekordowo wysoką. Jednocześnie sympatię do Rosjan deklaruje aż 8% polskiego społeczeństwa, a niechęć do Ukraińców aż 38% (w porównaniu do 15% w 2022 roku)[17].

Przy tak zarysowanym obrazie sytuacji trzeba odpowiedzieć sobie na pytanie, czy walka z dezinformacją w ogóle ma sens – a jeśli tak, to jak ją prowadzić. Skuteczność dezinformacji w niektórych bańkach informacyjnych jest bardzo wysoka, w innych zaś praktycznie żadna. To także potwierdza psychologiczne zjawisko naturalnego dążenia do szukania treści potwierdzających już posiadane poglądy[18]. Jest jednak znacząca grupa ludzi otwarta na poszukiwanie prawdy. Wobec rosnącego braku zaufania do treści w ogóle, warto stawiać na promocję rzetelnego dziennikarstwa i factcheckingu. Jednocześnie w pewnych rejonach świata, jak na przykład w Afryce, wysoką skutecznością wykazuje się stosowanie metod podobnych do tych, które stosują aktorzy rozsiewający dezinformację – tylko z przeciwstawnym wektorem[19]. Wysokie ceny dostępu do Internetu przenoszą wojnę informacyjną na poziom wiadomości tekstowych na komunikatorach takich jak Whatsapp. Badanie pokazuje, że metody te można stosować także w szczytnym celu.

Podstawą walki z dezinformacją pozostaje jednak edukacja. Uświadamianie społeczeństwa na temat zagrożeń potęgowanych przez rozwój technologiczny i budowanie odpowiedzialnego podejścia do korzystania z usług cyfrowych jest niezbędnym elementem tworzenia świadomego społeczeństwa obywatelskiego odpornego na manipulację. Niestety, dzisiaj hasło „włącz myślenie” oznacza odcięcie się od rzetelnych źródeł i oparcie swojej wiedzy na sensacyjnych historiach generowanych przez AI albo na tezach populistycznych polityków budujących tym swój kapitał wyborczy.

Walka z dezinformacją jest z pewnością trudna i niewdzięczna, ale jest potrzebna. Potrzeba ta ciągle wzrasta wobec intensyfikacji działań hybrydowych ze strony Federacji Rosyjskiej. Dzisiaj walka z dezinformacją to kwestia bezpieczeństwa narodowego i międzynarodowego – dlatego trzeba dążyć do zwiększania jej efektywności nie zrażając się – czasami pozorną – przewagą agresora. Nie można jednak zapomnieć, że edukacja to proces na długie lata, a zagrożenie obecne jest tu i teraz.

Walter Lippmann ponad sto lat temu w swojej książce „Opinia publiczna” zdefiniował trójkąt zależności między świadomością a rzeczywistością. Nasza percepcja realnie istniejącego świata przekłada się na obraz, który sobie tworzymy i to na jego podstawie, a nie bezpośrednio na podstawie faktów podejmujemy działania, które mają już wymierne skutki w świecie materialnym. Dlatego wojna informacyjna ma szczególne znaczenie – bo choć pozornie toczy się na poziomie abstrakcyjnym, to jej skutki mają już konkretny wymiar.

[1] BAD BOT REPORT The Rapid Rise of Bots and the Unseen Risk for Business, Interva, 2025, https://www.imperva.com/resources/gated/reports/2025-Bad-Bot-Report.pdf

[2] Self-Replicating Prompts for Large Language Models: Towards Artificial Culture, LMU Munich, 22.07.2024, https://direct.mit.edu/isal/proceedings/isal2024/36/110/123523

[3] Kristian Hammond, Degenerative AI: The Risks of Training Systems on their own Data, 6.09.2024, https://casmi.northwestern.edu/news/articles/2024/degenerative-ai-the-risks-of-training-systems-on-their-own-data.html

[4] John Maynor, Flood the Zone with Shit: Algorithmic Domination in the Modern Republic, 19 June 2025, MDPI, https://www.mdpi.com/2076-0760/14/6/391

[5] Ashley WennersHerron, Social media users probably won’t read beyond this headline, researchers say, 19.11.2024, Pennsylvania State University, https://www.psu.edu/news/research/story/social-media-users-probably-wont-read-beyond-headline-researchers-say

[6] Pietro Nickl, Mehdi Moussaïd, Philipp Lorenz-Spreen, The evolution of online news headlines, 13.03.2025, [w:] Humanities and Social Sciences Communications, https://www.nature.com/articles/s41599-025-04514-7#author-information

[7] Rosyjska propaganda podsyca antyukraińskie nastroje, 3.06.2025, Euractiv, https://euractiv.pl/section/grupa-wyszehradzka/news/rosyjska-propaganda-podsyca-w-naszym-regionie-antyukrainskie-nastroje

[8] Ashley WennersHerron, Social media users probably won’t read beyond this headline, researchers say, 19.11.2024, Pennsylvania State University, https://www.psu.edu/news/research/story/social-media-users-probably-wont-read-beyond-headline-researchers-say

[9] Trust, attitudes and use of Artificial Intelligence: A global study 2025, University of Melbourne&KPMG, 2025, https://kpmg.com/xx/en/our-insights/ai-and-technology/trust-attitudes-and-use-of-ai.html

[10] Jessica Brandt, An information strategy for the United States, 5.05.2023, Brookings, https://www.brookings.edu/articles/an-information-strategy-for-the-united-states

[11] Michael Baggs, Instagram: Why paying for followers and likes is bad news for real fans, 13.07.2019, BBC, https://www.bbc.com/news/newsbeat-48952123

[12] The 2022 Code of Practice on Disinformation, https://digital-strategy.ec.europa.eu/en/policies/code-practice-disinformation

[13] Community-based fact-checking reduces the spread of misleading posts on social media, 13.09.2024, https://arxiv.org/html/2409.08781v1

[14] Vosoughi, S., Roy, D., & Aral, S. (2018). The spread of true and false news online, Science, https://news.mit.edu/2018/study-twitter-false-news-travels-faster-true-stories-0308

[15] Measuring receptivity to misinformation at scale on a social media platform, październik 2024, PNAS Nexus, Volume 3, Issue 10, https://academic.oup.com/pnasnexus/article/3/10/pgae396/7754768?login=false#485902606

[16] Sami Nenno, Separate worlds of misinformation. An explorative study of checked claims in German public broadcast news and talk shows, 22.09.2025, Taylor&Francis Online, https://www.tandfonline.com/doi/full/10.1080/1369118X.2025.2561030

[17] Stosunek Polaków do innych narodów, luty 2025, CBOS, https://www.cbos.pl/SPISKOM.POL/2025/K_013_25.PDF

[18] Sustaining Exposure to Fact-Checks: Misinformation Discernment, Media Consumption, and Its Political Implications, 20.02.2025, Cambridge Univeristy, https://www.cambridge.org/core/journals/american-political-science-review/article/sustaining-exposure-to-factchecks-misinformation-discernment-media-consumption-and-its-political-implications/C9CC3A0C7BAF7BADBEF0DA6350A875C8

[19] Combating Misinformation using Fact-Checking via WhatsApp in South Africa, lipiec 2023, Abdul Latif Jameel Poverty Action Lab, https://www.povertyactionlab.org/evaluation/combating-misinformation-using-fact-checking-whatsapp-south-africa