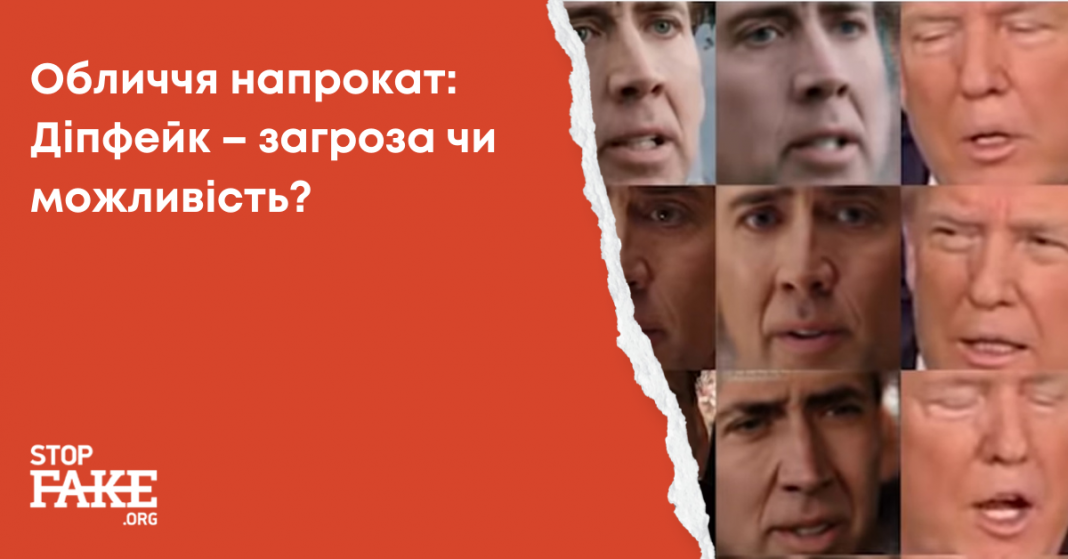

Діпфейк – загроза чи можливість?

Наталя ІЩЕНКО

Фейкові новини, дезінформація та маніпулятивні медійні кампанії стали повсякденної реальністю нашого часу. Ми постійно намагаємося протистояти навалі неправдивих повідомлень та спробам нас обдурити, але спеціалісти із несправжніх новин та маніпуляцій теж не сидять, склавши руки.

Одним з останніх етапів розвитку технологій виробництва підроблених повідомлень став механізм створення діпфейків. Журнал Массачусетського технологічного інституту в свіжому випуску назвав 2020-й рік «роком, коли діпфейки стали мейнстримом». Але все говорить про те, що і 2021-й буде «роком діпфейків».

Втім, є і хороші новини – ця технологія може бути використана не тільки зловмисниками і не тільки із деструктивними цілями.

ГЛИБОКА ПІДРОБКА

Діпфейк (deepfake, дослівно – глибока (deep) підробка (fake)) — механізм заміщення обличчя людини на відео обличчям іншої людини за допомогою штучного інтелекту, 3D-моделювання та нейромереж. Ця технологія стало широко відомою в 2018 році. Тоді журналісти знайшли користувача мережі Reddit, який публікував фейкові порнографічні відеоролики. Анонім використав алгоритм штучного інтелекту, щоб замінювати обличчя порноактерів на обличчя знаменитостей з інших сфер. Наступного року сфальшоване порно поширилося далеко за межі Reddit, завдяки легкодоступним додаткам, які могли «зняти» одяг із будь-кого.

З тих пір діпфейки активно використовуються для створення підробної порнографії або її «лайтверсії» – фальшивого «роздягання».

В жовтні цього року у соцмережах з’явилися фейкові фото понад 100 тисяч «оголених» жінок. Для створення знімків використали бот на основі штучного інтелекту з додатку у приватних повідомленнях месенджера Telegram. Його користувачі могли надіслати фото будь-якої жінки, і за лічені хвилини отримували її фальшиве зображення без одягу. Цікаво, що роботу бота супроводжувала масована рекламна кампанія у російській соціальній мережі ВКонтакте, що, разом із використанням також російського Telegram, натякає на походження розробки.

На думку Ніни Шик, автора книги “Діпфейки та Інфокаліпсис”, загалом кількість порнографії, виробленої за допомогою технології діпфейк, подвоюється щопівроку. Реальних людей, чиї зображення були використані для створення порнороликів, це може обурити і навіть нанести серйозну психологічну травму.

ДІПФЕЙК ЯК ЗАГРОЗА НАЦБЕЗПЕЦІ

Втім, експерти впевнені: фальшування порнографії – не найбільше зло, якого можна чекати від застосування технології діпфейк. Лунають прогнози про те, що цей високотехнологічний спосіб «підміни обличь» стане ефективним інструментом для реалізації шахрайських схем чи найсучаснішою зброєю інформаційних воєн.

З метою стимулювання розробки технологій, здатних автоматично розпізнавати діпфейки, закон про Оборонний бюджет США (NDAA) на 2020-й год передбачав проведення спеціального конкурсу. Призовий фонд складав 5 мільйонів доларів. Проводити конкурс мав департамент національної розвідки Сполучених Штатів.

Закон про оборонний бюджет на 2020 рік став першим законодавчим документом федерального рівня у США, в якому йдеться про «діпфейки». Пізніше на центральному рівні та на рівні штатів було розглянуто чи навіть ухвалено кілька нормативних актів, які мали попередити зловмисне розповсюдження фальшивих відео, створених із використанням штучного інтелекту.

Планується, що Закон про Оборонний бюджет США на 2021 рік буде приділяти ще більшу увагу проблемі використання діпфейків для дезінформації та маніпулювання. При чому, якщо в минулорічному документі йшлося, в основному, про протидію закордонним впливам, які загрожують національній безпеці, то тепер у Вашингтоні збираються боротися із фальшивками, які використовуються для “вчинення шахрайства”, заподіяння шкоди “вразливим групам” або порушують закони про громадянські права.

Втім, діпфейк – це технологія, яка не обов’язково загрожує нацбезпеці чи шкодить людям. Механізм заміни обличь все частіше використовують із благими намірами.

ФЕЙК ДЛЯ ЗАХИСТУ

Фільм-розслідування «Ласкаво просимо до Чечні» (Welcome to Chechnya) про репресії проти ЛГБТ-спільноти у північнокавказької республіці Російської Федерації, став першим документальним фільмом, який використовував фальшиві відео з метою захисту відомостей про особу своїх героїв.

Картина розказує про роботу активістів, які рятували жертв переслідувань у Чечні. Щоб уникнути викриття їхньої діяльності, зйомки велися таємно, із використанням прихованих камер, мобільних телефонів, GoPro та портативних «ручних» камер.

Ще одним ускладненням під час виробництва фільму стала необхідність нерозголошення відомостей про героїв фільму, тому автори не могли показати їх в кадрі.

Режисер Девід Франс (David France), репортер-розслідувач, хотів включити в картину справжні людські обличчя, тому звичайних прийомів маскування зовнішності, таких, як розмиття «картинки», зйомка в темряві чи залучення акторів для постановки реконструкцій, було недостатньо. Врешті-решт він зупинив свій вибір на вдосконалених техніках заміни обличчя із використанням штучного інтелекту та новітніх технологій візуальних ефектів, щоб глядач міг бачити реальні обличчя людей, що відображають справжні емоції, але при цьому особа співрозмовника залишалася в таємниці.

Для втілення в життя своєї ідеї Франс попросив інших ЛГБТ-активістів з усього світу «позичити» свої обличчя, які потім були «прищеплені» до обличь «втаємничених» учасників зйомок. Ця техніка дозволила зберегти природність міміки героїв, і передати їх емоції – біль, страх і гуманність. Загалом у фільм таким чином захищено 23 особи.

Використання технології створення діпфейків стало абсолютно новим інструментом в арсеналі журналістів-розслідувачів для приховування особистості «викривачів» чи таємних свідків.

ЛЯЛЬКИ НОВОЇ ЕРИ

Інша сфера застосування діпфейків – сатиричні телевізійні шоу.

В 1990-х роках на телебаченні різних країн були дуже популярні передачі, в яких «ролі» відомих політиків виконували ляльки-пародії на своїх прототипів, а кожен випуск розповідав про актуальні політичні події. (Наприклад, на російському НТВ виходила відома програма «Ляльки»).

Якщо замінити фігури з пап’є-маше на цифрові зображення, ми отримаємо сучасну версію «лялькового шоу», де ролі політиків виконують не ляльки, а діпфейки.

З жовтня цього року творці мультсеріалу «Південний парк» (South Park) почали випуск програми Sassy Justice – першого телешоу у форматі діпфейк. Щотижнева сатирична шоу програма обертається навколо персонажа Sassy Justice, «репортера новин» з фальшивим обличчям Трампа та в смішної перуці. (Роль виконує британський актор Петер Серафинович, відомий пародіями на Трампа). В ході передачі «журналіст-Трамп» бере інтерв’ю у таких саме фейкових персонажів. Наприклад, «Джареда Кушнера» (обличчя Кушнера накладено на дитину) чи «Ела Гора».

Треба сказати, що у такому карикатурному вигляді діпфейк вважається прийнятним. Принаймні Фейсбук не поширює свою антифейкову політику на вміст, який є пародією чи сатирою.

Втім, не факт, що таке поблажливе відношення до появи на телебаченні фейкових політиків збережеться і надалі.

ТАНЦЮЮЧА КОРОЛЕВА

Ось свіжий привід для роздумів.

Британський 4-й канал показав на Різдво «альтернативне» звернення королеви Єлизавети II, зроблене за допомогою технології діпфейку. У відеороліку знялася актриса з «цифровою зовнішністю» королеви Великої Британії. За допомогою комп’ютерних технологій, 48-річна Дебра Стефенсон виглядала майже точно так, як 94-річна Єлизавета ІІ. Але вела себе по іншому: вона жартівливо коментувала останні події в королівської родині та танцювала на столі.

Альтернативне привітання вийшло в ефір напередодні трансляції Бі-бі-сі офіційного щорічного телевізійного послання королеви до країни.

Вже через кілька днів до британського регулятора комунікацій Ofcom було подано сотні скарг через виступ фальшивої Єлизавети ІІ.

В свою чергу директор програм 4-го каналу Ян Кац заявив, що виступ «підробного монарха» мало бути “потужним нагадуванням” про можливості дезінформації. “Альтернативне різдвяне звернення цього року, яке, здавалося, виголосив один із найвідоміших діячів у країні, якому найбільш довіряють, є потужним нагадуванням про те, що ми більше не можемо довіряти власним очам”, – підкреслив він, зазначивши: “Технологія діпфейк – це лякаючий новий рубіж у битві між дезінформацією та правдою”.

В ролику 4-го каналу «підробна королева» завершує своє «Різдвяне звернення» словами: “Чи завжди те, що ми бачимо і чуємо, є таким, яким здається?”.

Вдале послання для Нового року, яке черговий раз нагадує нам про важливість критичного мислення та про обов’язковість перевірки і перепровірки всіх відомостей про людей та події – навіть тих, що спочатку здаються такими очевидними…