В ноябре 2017 года представители Facebook, Twitter и Google стали участниками слушаний в Конгрессе по поводу влияния публикуемого на их страницах контента на результаты выборов Президента США. За несколько недель до этого стали известны результаты расследования, которые показали, что в Twitter действовала сеть ботов, которая влияла не некоторые политические записи. А в Facebook размещалась политическая реклама манипулятивного характера, которая, благодаря принципу таргетирования, очень четко попадала в цель – ее видели те пользователи, которые демонстрировали релевантные политические интересы либо могли быть заинтересованы в таких объявлениях. Около полумиллиона фейковых аккаунтов «работали» на раскрутку такой рекламы не только в Facebook, но и на страницах YouTube, а увидели ее более 100 млн американцев, то есть около половины населения страны. Оказалось, что реклама закупалась и продвигалась так называемой «фабрикой троллей» из России, известной под названием «Агентство интернет-исследований».

После слушаний в Конгрессе Facebook сообщил о ряде изменений в работе с фейковыми новостями. Эти изменения показывают, что социальная сеть, по большому счету, находится в поиске правильных способов работы с фейковым контентом. Обо всех своих экспериментах Facebook детально рассказывает в своем блоге. Последние два месяца Facebook анонсировала сразу несколько изменений, связанных с работой с фейками, политической рекламой, ботами. Подробнее о них мы расскажем в этом материале.

Новости в контексте

В октябре, еще до старта полномасштабного расследования влияния «фабрики троллей» на выборы Facebook начала тестировать кнопку, демонстрирующую контекст статьи. С помощью этой кнопки пользователи могли увидеть связанные материалы с тем, который виден у них в новостной ленте.

Эта функция изначально работала только для пользователей из США, Франции, Нидерландов и Германии. Она позволяла увидеть материалы из доверенных источников и понять, действительно ли представленный контент заслуживает внимания и доверия. С помощью этой кнопки можно увидеть, какие пользователи распространяли этот контент и, самое главное, из каких стран они были.

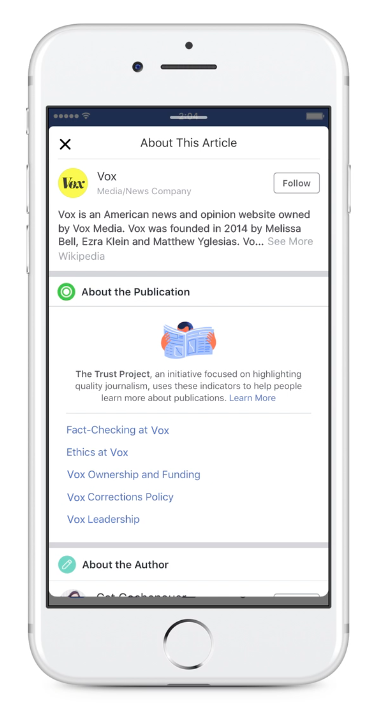

Индикатор доверия

Еще один инструмент, который Facebook начал тестировать для определения фейкового контента – отображение специальных индикаторов доверия (Trust Indicators). Эта функция стартовала совместно с проектом Trust Project.

Рядом со ссылкой отображалась кнопка, нажав на которую пользователи могли узнать, кто является владельцем медиа, распространяющим контент, какая у издания политика относительно проверки информации и этичных норм.

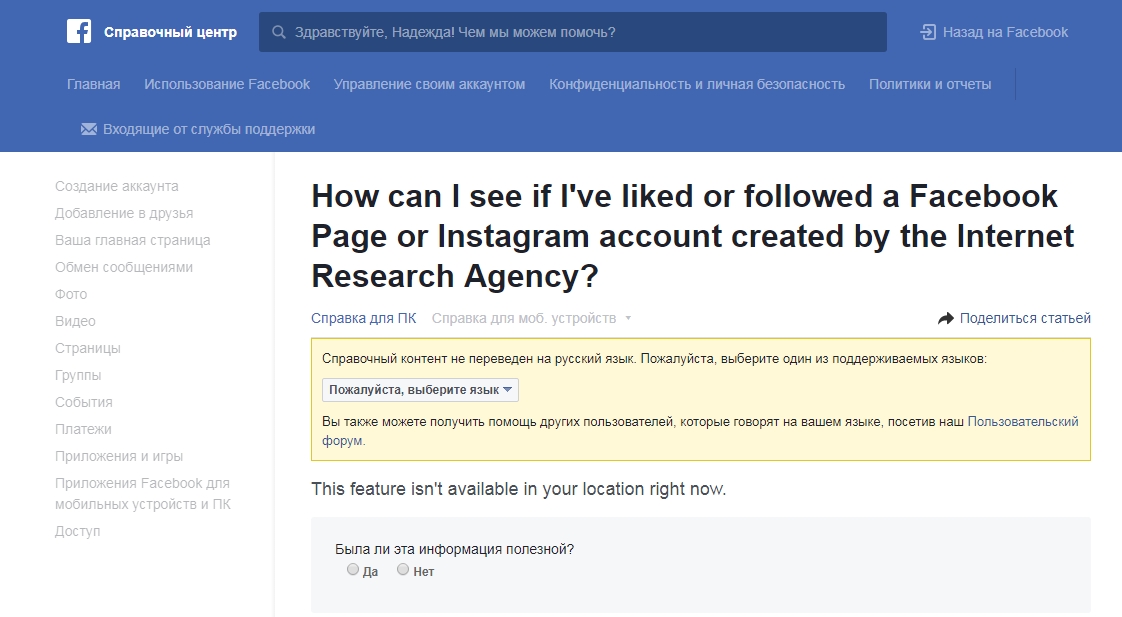

Как найти жертв пропаганды

В ноябре Facebook пообещала запустить инструмент, который бы позволил людям узнать, реагировали ли они на записи, созданные «фабрикой троллей» в период с января 2015 по август 2017 года.

В конце декабря этот портал стал доступен американцам через Справочный центр социальной сети. В справке Facebook появилась страница с ответом на вопрос «Как я могу узнать, нравилась ли мне или следил ли я за аккаунтом в Facebook или Instagram, созданным Агентством интернет-исследований». В ответ на этот вопрос жителям США соцсеть показывает список страниц, созданных «фабрикой троллей».

К сожалению, для украинцев сервис недоступен – его создали специально для жертв пропаганды из США и Великобритании, то есть тех людей, которые доказано могли просматривать и реагировать в процессе выборов или голосования за Брексит на посты «фабрики троллей».

Новый сервис показывает список подозрительных аккаунтов только тем, кто взаимодействовал с их записями. Однако пока нельзя узнать, взаимодействовали ли с ними друзья пользователя, то есть видел ли человек в своем Facebook-фиде «лайки» этих записей.

Отказ от пометки фактчекеров

Одновременно с этим Facebook заявила, что отказывается от пометки Disapproved Flags, внедренной год назад и говорящей и том, что новость не была проверена фактчекерами либо является сомнительной с их точки зрения. Дизайнеры и разработчики интерфейса Facebook написали подробный пост на @Medium с объяснением своего решения.

В Facebook пришли к выводу, что такая отметка не убеждает пользователей в том, что они просматривают сомнительный контент, а, как ни парадоксально, увеличивает интерес к нему, что отображается в увеличении количества взаимодействий: лайков и репостов. А это прямо противоположно тому, чего Facebook добивалась, запуская эту функцию. В то же время, функция «похожие публикации» работает лучше и люди чаще просматривают достоверные публикации из других источников.

Этим нововведением Facebook подтвердила, что для модели распространения контента в социальной сети не работают правила, которые работают в традиционных медиа. Предложение «почитать еще» на ту или иную тему может и срабатывало для определенных видов контента, но вряд ли оно использовалось бы для постов манипулятивного содержания – тех, которыми активно «промышляла» российская фабрика троллей. А это значит, что социальной сети предстоит еще много работать в направлении борьбы с фейковым контентом.

Битва еще не выиграна, но будет ли выиграна война?

Издание Bloomberg каждый год публикует так называемый «гид пессимиста». В нем аналитики и журналисты собирают самые неприятные события, которые могут случиться в ближайшее десятилетие.

В новом прогнозе эксперты упомянули Facebook и фейковые новости. Аналитики считают, что Facebook в отдаленной перспективе проиграет борьбу с фейками. Сама суть соцмедиа не позволит им бороться с недостоверной информацией и пропагандой, а активность ботов и поддельных аккаунтов будет настолько сильной, что люди просто не смогут различать правду и ложь.

Большинство прогнозов из «гида пессимиста» обычно не сбываются. Это и понятно: в Bloomberg часто моделируют невероятные стечения обстоятельств, а иногда и откровенный абсурд. Однако сам факт попадания соцмедbа и фейковых новостей в этот список говорит о том, что риск превращения Facebook, Twitter, Instagram и других проектов, построенных на user generated content, в платформу для глобальных фейков достаточно реален.

Расследование Конгресса привело к некоторым изменениям в работе Facebook с фейковым контентом. Однако эти изменения выглядят как косметический ремонт после серьезного пожара. Компании придется построить другую модель взаимодействия с пользовательским контентом, другой способ формирования новостного фида, изменить принципы реакции на спорный контент, иначе прогнозы из «гида пессимиста» от Bloomberg рискуют стать реальностью.

Автор: Надежда Баловсяк, для Stopfake.org.