У листопаді 2017 року представники Facebook, Twitter і Google стали учасниками слухань у Конгресі з приводу впливу публікованого на їхніх сторінках контенту на результати виборів Президента США. За кілька тижнів до цього стали відомі результати розслідування, які показали, що у Twitter діяла мережа ботів, яка впливала на деякі політичні записи. А в Facebook розміщувалася політична реклама маніпулятивного характеру, яка, завдяки принципу таргетування, дуже чітко влучала в ціль – її бачили ті користувачі, які демонстрували релевантні політичні інтереси або могли бути зацікавлені в таких оголошеннях. Близько півмільйона фейкових акаунтів «працювали» на розкручування такої реклами не тільки у Facebook, а й на сторінках YouTube, а побачили її більш як 100 млн американців, тобто близько половини населення країни. Виявилося, що реклама закуповувалася і просувалася так званою «фабрикою тролів» з Росії, відомою під назвою «Агентство інтернет-досліджень».

Після слухань у Конгресі Facebook повідомив про ряд змін у роботі з фейковими новинами. Ці зміни показують, що соціальна мережа, фактично, перебуває в пошуку правильних способів роботи з фейковим контентом. Про всі свої експерименти Facebook детально розповідає у своєму блозі. Останні два місяці Facebook анонсував відразу декілька змін, пов’язаних з роботою з фейками, політичною рекламою, ботами. Детальніше про них ми розповімо в цьому матеріалі.

Новини в контексті

У жовтні, ще до старту повномасштабного розслідування впливу «фабрики тролів» на вибори, Facebook почала тестувати кнопку, яка демонструвала б контекст статті. За допомогою цієї кнопки користувачі могли побачити пов’язані матеріали з тим, який видно у них у новинній стрічці.

Ця функція спочатку працювала тільки для користувачів зі США, Франції, Нідерландів і Німеччини. Вона давала змогу побачити матеріали з довірених джерел і зрозуміти, чи справді цей контент заслуговує на увагу і довіру. За допомогою цієї кнопки можна побачити, які користувачі поширювали цей контент і, найголовніше, з яких країн вони були.

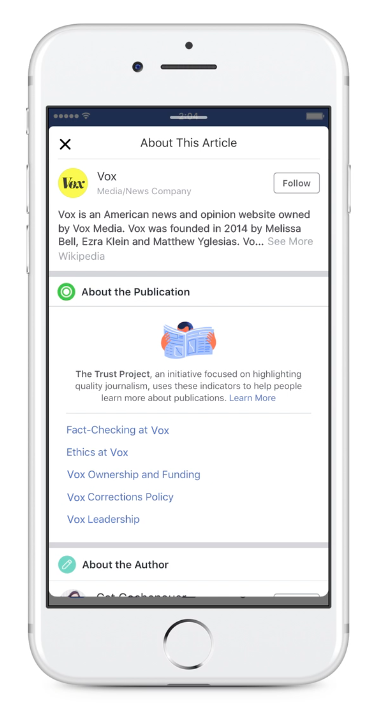

Індикатор довіри

Ще один інструмент, який Facebook почав тестувати для визначення фейкового контенту – відображення спеціальних індикаторів довіри (Trust Indicators). Ця функція стартувала спільно з проектом Trust Project.

Поруч із посиланням відображалася кнопка, натиснувши на яку, користувачі могли дізнатися, хто є власником медіа, що поширює контент, яка у видання політика щодо перевірки інформації та етичних норм.

Як знайти жертв пропаганди

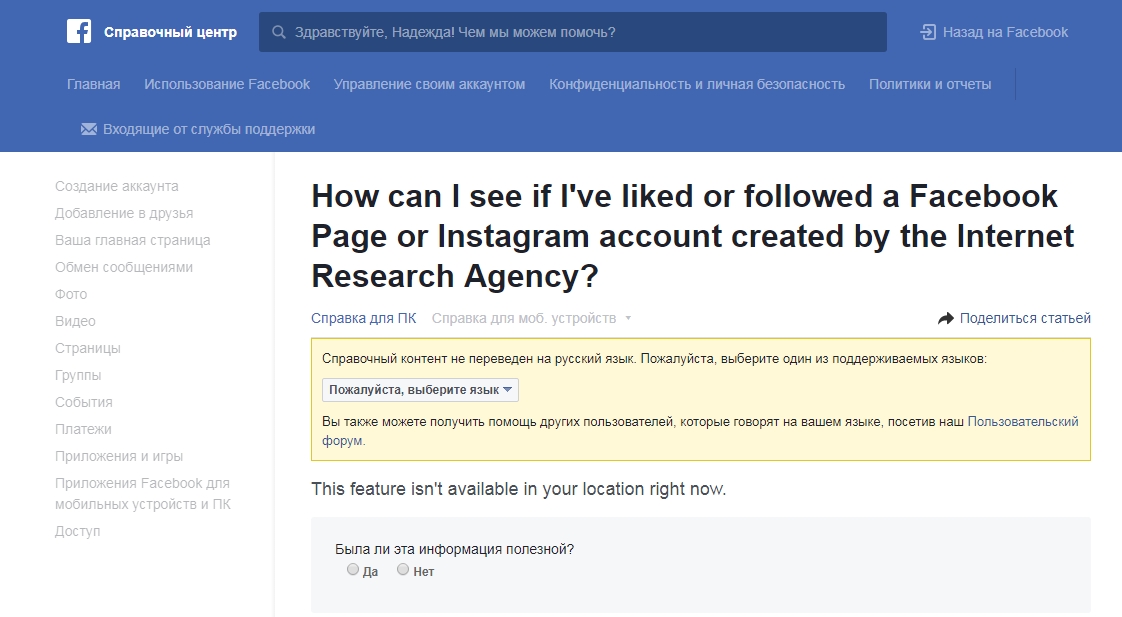

У листопаді Facebook пообіцяла запустити інструмент, який дав би людям змогу дізнатися, чи реагували вони на записи, створені «фабрикою тролів» у період з січня 2015 по серпень 2017 року.

У кінці грудня цей портал став доступний американцям через Довідковий центр соціальної мережі. У довідці Facebook з’явилася сторінка з відповіддю на запитання «Як я можу дізнатися, чи подобався мені або чи стежив я за акаунтом у Facebook або Instagram, створеним Агентством інтернет-досліджень». У відповідь на це питання жителям США соцмережа показує список сторінок, створених «фабрикою тролів».

На жаль, для українців сервіс недоступний – його створили спеціально для жертв пропаганди зі США і Великобританії, тобто тих людей, які доведено могли переглядати і реагувати в процесі виборів або голосування за Брексіт на дописи «фабрики тролів».

Новий сервіс показує перелік підозрілих акаунтів тільки тим, хто взаємодіяв з їхніми записами. Однак поки не можна дізнатися, чи взаємодіяли з ними друзі користувача, тобто чи бачила людина в своєму Facebook-фіді «уподобайки» цих записів.

Відмова від позначки фактчекерів

Одночасно з цим Facebook заявив, що відмовляється від позначки Disapproved Flags, впровадженої рік тому, яка свідчила про те, що новина не була перевірена фактчекерами або є сумнівною з їх погляду. Дизайнери і розробники інтерфейсу Facebook написали докладний пост на @Medium з поясненням свого рішення.

У Facebook дійшли висновку, що така оцінка не переконує користувачів у тому, що вони переглядають сумнівний контент, а, як не парадоксально, збільшує інтерес до нього, що відображається у збільшенні кількості взаємодій: уподобайок і репостів. А це прямо протилежно тому, чого Facebook домагалася, запускаючи цю функцію. Водночас, функція «схожі публікації» працює краще, і люди частіше переглядають достовірні публікації з інших джерел.

Цим нововведенням Facebook підтвердив, що для моделі розповсюдження контенту в соціальній мережі не працюють правила, які працюють у традиційних медіа. Пропозиція «почитати ще» на ту чи іншу тему може і спрацьовувала для певних видів контенту, та навряд чи вона використовувалася б для дописів маніпулятивного змісту – тих, якими активно «промишляла» російська фабрика тролів. А це означає, що соціальній мережі треба ще багато працювати в напрямку боротьби з фейковим контентом.

Битва ще не виграна, але чи буде виграна війна?

Видання Bloomberg щороку публікує так званий «гід песиміста». У ньому аналітики і журналісти збирають найнеприємніші події, які можуть статися в найближче десятиліття.

У новому прогнозі експерти згадали Facebook і фейкові новини. Аналітики вважають, що Facebook у віддаленій перспективі програє боротьбу з фейками. Сама суть соцмедіа не дозволить їм боротися з недостовірною інформацією і пропагандою, а активність ботів і підроблених акаунтів буде настільки сильною, що люди просто не зможуть розрізняти правду і брехню.

Більшість прогнозів з «гіда песиміста» зазвичай не збуваються. Це і зрозуміло: у Bloomberg часто моделюють неймовірні збіги обставин, а іноді й відвертий абсурд. Однак сам факт потрапляння соцмедіа і фейкових новин до цього списку свідчить про те, що ризик перетворення Facebook, Twitter, Instagram та інших проектів, побудованих на user generated content, у платформу для глобальних фейків, досить реальний.

Розслідування Конгресу призвело до деяких змін у роботі Facebook з фейковим контентом. Однак ці зміни виглядають як косметичний ремонт після серйозної пожежі. Компанії доведеться побудувати іншу модель взаємодії з призначеним для користувача контентом, інший спосіб формування новинної стрічки, змінити принципи реакції на спірний контент, інакше прогнози з «гіда песиміста» від Bloomberg ризикують стати реальністю.

Автор: Надія Баловсяк, для Stopfake.org.