Распространение фейковых новостей без социальных сетей, их алгоритмов и механизмов работы было бы невозможным. Именно социальные сети способствуют распространению фейков с одной стороны, и не могут справиться с аккаунтами, создаваемыми для вбросов и взрывов информационно-манипулятивных бомб. Поэтому подготовка социальных сетей к промежуточным выборам в Конгресс, состоявшимся 6 ноября, была своеобразной проверкой сил перед настоящей битвой, которая состоится через два года – к очередным выборам президента США.

Fake News – серьезнее, чем все думали

Уже не нужно никого убеждать в том, что фейковые новости являются мощным инструментом влияния на общественное мнение. Анализ избирательной кампании 2016 года и последующие разоблачения деятельности российского Агентства интернет-новостей доказали это. А если к этому добавить и утечки пользовательских данных (о которых рассказала история с Cambridge Analytica), инструменты микротаргетинга социальных сетей и манипулятивный контент, активно распространяемый идеологическими соперниками, то фейки превращаются в одну из главных онлайновых проблем избирательных кампаний.

Пока попытки борьбы с этой проблемой носят, условно говоря, точечный и несистематический характер. А глобального механизма, который бы позволил побороть эту проблему, так и не было создано. И это несмотря на появление новых технологий работы с информацией (например, блокчейна).

Главные фигуранты скандалов с фейковыми новостями — социальные сети — вкладывают немалые деньги в то, чтобы научиться идентифицировать фейковый контент и аккаунты, созданные для его продвижения. Первоначальная риторика Facebook, которую можно было охарактеризовать девизом «еще больше модераторов», постепенно стала меняться и крупнейшая социальная сеть стала двигаться в сторону алгоритмических методов идентификации фейков.

Промежуточные выборы стали хорошим способом проверить эффективность если не разработанных методов и инструментов, то, по крайней мере, правильности пути, по которому движутся компании. Попробуем оценить, насколько успешным было это «полевое испытание».

Как социальные сервисы готовились к промежуточным выборам

Цукерберг не скрывал важность грядущих выборов для компании, по крайней мере последние несколько месяцев до выборов он всячески подчеркивал, что компания разрабатывает новые инструменты и механизмы борьбы с фейками.

Действия Facebook по подготовке к промежуточным выборам, можно объединить в решение трех главных задач:

— Научиться находить и удалять «поддельные» или фейковые аккаунты

— Научиться находить и уменьшить распространение так называемых фейковые новостей

— Усложнить покупку рекламы, которая продвигает кандидатов или важные для избирательного процесса темы, или рекламы, которая очерняет конкурентов и является манипулятивной.

Вот как Facebook пыталась решить эти задачи

“Военная комната”

В средине октября в медиа появилась информация о том, что в офисе Facebook появилась специальная «военная комната» (War Room) . В ней заработало специальное подразделение, занятое борьбой с фейками. На момент старта в этом подразделении работало 20 экспертов по аналитике и программированию, а в будущем их число должно было вырасти до 20 тысяч. Кроме того, в «военной комнате» установлены мониторы, анализирующие распространение контента и используется специальное аналитическое ПО, способное, по словам представителей компании, идентифицировать и выделять фейки, а также оперативно на них реагировать, практически в режиме реального времени.

Само название «военная комната» говорит о том, что Facebook весьма серьезно отнеслись к борьбе с фейками, как явлением, и что в компании идентифицируют борьбу с ними с настоящими военными действиями.

Самид Чакрабарти (Samidh Chakrabarti), менеджер Facebook заявил, что работа этой “комнаты” была испытана во время выборов в Бразилии в начале октября, где компания столкнулась с массовым распространением контента, направленного на снижение явки избирателей».

Искусственный интеллект против фейков

Комментируя подготовку к промежуточным выборам и рассказывая о борьбе с фейками, Цукерберг не забывает повторять ставшее мантрой утверждение о необходимости «еще больше модераторов». Так в своем Facebook-аккаунте в сентябре этого года глава компании опубликовал большую заметку под названием «Подготовка к выборам» (Preparing for Elections).

В ней Марк Цукерберг рассказал, что в 2016 году компания не воспринимала серьезно иные угрозы, кроме традиционных — фишинг, хакерская деятельность и вредоносные программы и не ожидала скоординированных действий из-за рубежа и появления целых сетей фейковых аккаунтов, распространяющих ненависть и дезинформацию.

За последний год Facebook обнаружил и удалил ряд фейковых аккаунтов, нацеленных на вмешательство в выборы во Франции, Германии, Мексике и Бразилии, нивелировала кампании по иностранному влиянию из России и Ирана, пытающиеся воздействовать на ход выборов в США, Великобритании и странах Ближнего Востока, а также предупредили деятельность групп из Мексики и Бразилии, которые были направлены на пользователей из собственных стран. Также Фейсбук пытался решить задачу по блокировке рекламы.

Самым важным изменением 2018 года стала автоматическая система блокировки фейковых аккаунтов, которая умеет идентифицировать и удалять фейковый аккаунт за короткое время.

«В общей сложности мы удалили более одного миллиарда поддельных аккаунтов — подавляющее большинство в течение нескольких минут после создания и до того, как они смогли нанести какой-либо вред — за шесть месяцев с октября по март. Выявление и удаление этих кампаний затруднено, потому что объем деятельности в наших сервисах настолько велик», — поясняет Цукерберг

В Facebook определили, что фейковый контент распространяется тремя основными способами:

- поддельными аккаунтами, в том числе политически мотивированными

- спамерами, благодаря экономической мотивации (то есть за деньги)

- обычными людьми, которые часто могут не знать, что они распространяют дезинформацию.

«Третья, основная категория фейков, распространяется обычными людьми в их обычном использовании Facebook. С таким распространением фейков бороться сложнее всего, потому что остановить его практически невозможно, в отличие от других ситуаций, когда мы удаляем поддельные аккаунты или не позволяем спамерам использовать нашу рекламу. Вместо этого, когда сообщение помечено как потенциально ложное или вирусное, мы передаем его независимым фактчекерам для проверки. Все используемые нами сервисы проверки фактов сертифицированы Международной сетью проверки фактов . Посты, оцениваемые как ложные, понижаются в ленте и теряют в среднем 80% их будущих просмотров», — пояснил основные пути борьбы с фейками Марк Цукерберг.

Алгоритмическая проверка фотографий

Проверка фотографий и видеоконтента считается одной из самых сложных задач в работе фактчекера. Сложно научить алгоритм понимать, что изображено на фото и действительно ли там представлен манипулятивный контент. Тем не менее, в Facebook попытались решить и эту задачу, объединив усилия людей с алгоритмами.

В сентябре этого Facebook запустила проверку изображений и видео совместно с 27 партнерах в 17 странах мира. В компании сообщили, что алгоритмы, работающие на основе искусственного интеллекта, будут отслеживать медиаконтент и проверять его по нескольким критериям.

Среди них – обратная связь от пользователей (комментарии), а также косвенные признаки проблемного контента. Подозрительные фото отправляются фактчекерам, которые проверяют их, например, анализируя метаданные изображений или то, когда и где была сделана фотография или видео.

https://www.facebook.com/facebook/videos/2169674999973363/

По мере того, как компания получает больше оценок от фактчекеров относительно фотографий и видео, компания может повысить точность ее модели машинного обучения. Иными словами, работа фактчекеров и результаты их проверки позволяют обучать алгоритмы автоматическому распознаванию фейковых и манипулятивных изображений. Наряду с этим Facebook использует и другие техники, чтобы лучше распознавать ложный или вводящий в заблуждение контент, например, оптическое распознавание символов (OCR) для извлечения текста из фотографий и сравнения этого текста с заголовками статей.

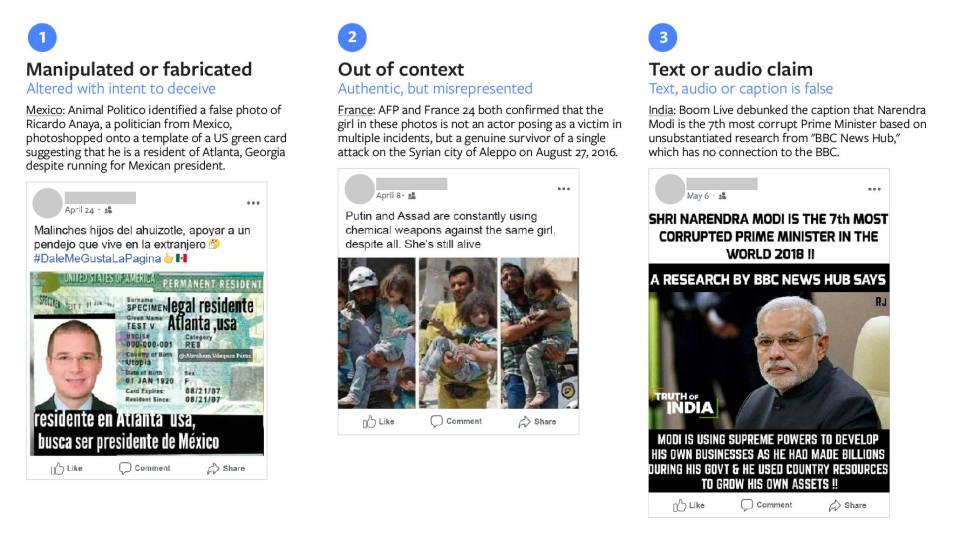

В Facebook отмечают, что дезинформация в фотографиях и видео обычно делится на три категории:

— манипулятивный или сфабрикованный контент

— вырванный из контекста контент

— текст изображения, на которых размещена лживая информация.

Компания обещает, что подозрительные фото и видео, получившие низкие оценки и считающиеся подозрительными для потенциального фейкового контента, получат специальную маркировку.

Рейтинг доверия пользователей

В конце лета Facebook ввел алгоритм, с помощью которого компания оценивает репутацию пользователя и формирует его условную оценку – рейтинг надежности или рейтинг доверия. В Facebook отмечают, что такой рейтинг поможет компании бороться с распространением фейковых новостей.

Алгоритм будет не только анализировать пользовательский контент, но и учитывать жалобы. Если пользователи будут жаловаться на чужие фейковые записи, их рейтинг будет расти.

Примечательно, что компания не планирует раскрывать подробности работы этого алгоритма соцсети, чтобы пользователи не занялись манипулированием.

Что показали выборы

На самом деле оценить эффективность действий Facebook можно будет только в отдаленной перспективе. Не исключено, что через несколько месяцев станет известно, что очередное условное Агентство интернет-новостей занималось активным вбросом манипулятивной рекламы, которую не смогли идентифицировать модераторы и алгоритмы социальной сети.

Пока же в новостях появилась информация об отдельных случаях блокировки аккаунтов и удаления отдельных материалов. Эта информация может расцениваться неоднозначно. С одной стороны, это может говорить о том, что крупнейшая соцсеть не справилась, допустив ближе к дате голосования существование и активную деятельность аккаунтов, распространяющих фейки. С другой, факт их обнаружения можно считать демонстрацией эффективности инструментов и методик Facebook.

В октябре стало известно, что Facebook запретит публиковать ложную информацию о требованиях к голосованию и проверке фактов поддельных сообщений о насилии или длинных очередях на избирательных участках.

Накануне выборов компания рассказала о своей подготовке к дню голосования и о том, что она выявила 30 учетных записей Facebook и 85 учетных записей Instagram, которые могут участвовать в скоординированном недобросовестном поведении, все они были заблокированы. С этими Facebook-аккаунтами были связаны записи на русском и французском языках.

Позже появилась информация о блокировке более 800 страниц и аккаунтов пользователей за распространение фейков. Эти 559 страниц и 251 аккаунт занимались распространением спама и активизировались как раз незадолго до проведения промежуточных выборов в США.

Новые риторика, инструменты и подходы в борьбе с фейками

То, как проходила подготовка в Facebook к промежуточным выборам, внимание компании к проблеме фейков, детальные сообщения о том, что компания делает и почему она это делает – очень важное изменение и для социальной сети, и для всего интернет-пространства. Игнорировать проблему фейков на сегодняшний день уже нельзя и, наконец, в Facebook это поняли и стали об этом говорить. И говорить не всегда в разрезе всем знакомых понятий «тысячи и десятки тысяч модераторов контента».

Компания стала тратить деньги на борьбу с фейками, и не только в виде оплаты работы модераторов, а еще и на создание алгоритмов и инструментов определения фейков. Вряд ли инвесторы в восторге от таких затрат, вероятно, довольно значительных и влияющих на финансовые показатели компании, однако другого пути в нынешних условиях у Facebook просто нет. Самообучающиеся алгоритмы определения фейков, пусть и работающие в тесной связке с фактчекерами, наверняка являются предметом интереса Facebook не только как решения, помогающие определить фейковые и манипулятивные посты. Такие алгоритмы помогут компании и в разработке инструментов оценки рекламы, качества контента и других решений, которые Facebook позже сможет монетизировать.

Не исключено, что в компании понимают, что борьба с фейками теперь для нее – бесконечная во времени задача, которую ей придется решать постоянно. И постоянно бороться с улучшением инструментов и навыков тех, кто эти фейки распространяет.

Автор: Надежда Баловсяк, для Stopfake.org.