Поширення фейкових новин без соціальних мереж, їхніх алгоритмів і механізмів роботи було б неможливим. Саме соціальні мережі сприяють поширенню фейків з одного боку, та не можуть впоратися з акаунтами, які створюються для вкидань і вибухів інформаційно-маніпулятивних бомб. Тому підготовка соціальних мереж до проміжних виборів до Конгресу, що відбулися 6 листопада, була своєрідною перевіркою сил перед справжньою битвою, яка очікується через два роки – черговими виборами президента США.

Fake News – більш серйозно, ніж усі думали

Вже не потрібно нікого переконувати в тому, що фейкові новини є потужним інструментом впливу на громадську думку. Аналіз виборчої кампанії 2016 року і наступні викриття діяльності російського Агентства інтернет-новин довели це. А якщо додати до переліченого ще й витік даних користувачів (про які розповіла історія з Cambridge Analytica), інструменти мікротаргетінга соціальних мереж і маніпулятивний контент, який активно поширюють ідеологічні суперники, то фейки перетворюються на одну з основних онлайнових проблем виборчих кампаній.

Поки спроби боротьби з цією проблемою носять, умовно кажучи, точковий і несистематичний характер. А глобального механізму, який би дозволив впоратися із цією проблемою, так і не було створено. І це незважаючи на появу нових технологій роботи з інформацією (наприклад, блокчейна).

Головні фігуранти скандалів з фейковими новинами – соціальні мережі – вкладають чималі кошти в те, щоб навчитися ідентифікувати фейковий контент і акаунти, створені для його просування. Початкова риторика Facebook, яку можна було охарактеризувати девізом «ще більше модераторів», поступово почала змінюватися, і найбільша соціальна мережа нині рухається в бік алгоритмічних методів ідентифікації фейків.

Проміжні вибори стали добрим способом перевірити ефективність якщо не розроблених методів та інструментів, то, принаймні, правильності шляху, яким рухаються компанії. Спробуємо оцінити, наскільки успішним було це «польове випробування».

Як соціальні сервіси готувалися до проміжних виборів

Цукерберг не приховував важливість майбутніх виборів для компанії, принаймні останні декілька місяців до виборів він всіляко підкреслював, що компанія розробляє нові інструменти і механізми боротьби з фейками.

Дії Facebook з підготовки до проміжних виборів можна об’єднати у вирішення трьох головних завдань:

– Навчитися знаходити і видаляти «підробні» або фейкові акаунти

– Навчитися знаходити і зменшувати поширення так званих фейкових новин

– Ускладнити купівлю реклами, яка просуває кандидатів або важливі для виборчого процесу теми, або маніпулятивної і спрямованої на очорнення конкурентів реклами.

Ось у який спосіб Facebook намагався вирішити ці завдання:

«Військова кімната»

У середині жовтня в медіа з’явилася інформація про те, що в офісі Facebook з’явилася спеціальна «військова кімната» (War Room). У ній розпочав роботу спеціальний підрозділ, зайнятий боротьбою з фейками. На момент старту в цьому підрозділі працювало 20 експертів з аналітики та програмування, а в майбутньому їхня кількість мала зрости до 20 тисяч. Крім того, у «військовій кімнаті» встановлені монітори, що аналізують поширення контенту та використовується спеціальне аналітичне ПЗ, здатне, за словами представників компанії, ідентифікувати і виділяти фейки, а також оперативно на них реагувати, практично в режимі реального часу.

Сама назва «військова кімната» говорить про те, що у Facebook вельми серйозно поставилися до боротьби з фейками як явищем, і що в компанії ідентифікують боротьбу з ними зі справжніми військовими діями.

Самід Чакрабарті (Samidh Chakrabarti), менеджер Facebook заявив, що робота цієї «кімнати» була випробувана під час виборів у Бразилії на початку жовтня, де компанія зіткнулася з масовим поширенням контенту, спрямованого на зниження явки виборців».

Штучний інтелект проти фейків

Коментуючи підготовку до проміжних виборів і розповідаючи про боротьбу з фейками, Цукерберг не забуває повторювати твердження, котре вже перетворилося на мантру, щодо необхідності «ще більшої кількості модераторів». Так у своєму Facebook-акаунті у вересні цього року глава компанії опублікував велику замітку під назвою «Підготовка до виборів» (Preparing for Elections).

У ній Марк Цукерберг розповів, що в 2016 році компанія не сприймала серйозно інші загрози, окрім традиційних – фішинг, хакерська діяльність та шкідливі програми і не очікувала скоординованих дій з-за кордону і появи цілих мереж фейкових акаунтів, що поширюють ненависть і дезінформацію.

За останній рік Facebook виявив і вилучив ряд фейкових акаунтів, спрямованих на втручання у вибори у Франції, Німеччині, Мексиці та Бразилії, нівелював кампанії іноземного тиску із Росії та Ірану, які намагалися впливати на перебіг виборів у США, Великобританії і країнах Близького Сходу, а також запобіг діяльність груп із Мексики та Бразилії, які були націлені на користувачів з власних країн. Також Фейсбук намагався вирішити задачу із блокування реклами.

Найважливішою зміною 2018 року стала автоматична система блокування фейкових акаунтів, яка вміє ідентифікувати і видаляти фейковий аккаунт за короткий час.

«Загалом ми видалили понад один мільярд підроблених аккаунтів – переважну більшість протягом декількох хвилин після створення і до того, як вони змогли заподіяти якої-небудь шкоди – за шість місяців, з жовтня по березень. Виявлення і видалення цих кампаній ускладнюється тим, що обсяг діяльності в наших сервісах настільки великий», – пояснює Цукерберг

У Facebook визначили, що фейковий контент поширюється трьома основними способами:

- підробленими акаунтами, зокрема політично вмотивованими

- спамерами , завдяки економічній мотивації (тобто за гроші)

- звичайними людьми, які часто можуть не знати, що вони поширюють дезінформацію.

«Третя, основна категорія фейків, поширюється звичайними людьми під час їх звичайного використання Facebook. З таким поширенням фейків боротися найважче, тому що зупинити його практично неможливо, на відміну від інших ситуацій, коли ми видаляємо підроблені акаунти або не дозволяємо спамерам використовувати нашу рекламу. Замість цього, коли повідомлення позначено як потенційно помилкове або вірусне, ми передаємо його незалежним фактчекерам для перевірки. Усі сервіси перевірки фактів, які ми використовуємо, сертифіковані Міжнародною мережею перевірки фактів. Пости, що оцінюються як помилкові, знижуються в стрічці і втрачають в середньому 80% їх майбутніх переглядів», – пояснив основні шляхи боротьби з фейками Марк Цукерберг.

Алгоритмічна перевірка фотографій

Перевірка фотографій і відеоконтенту вважається одним із найскладніших завдань в роботі фактчекера. Складно навчити алгоритм розуміти, що зображено на фото і чи дійсно там представлений маніпулятивний контент. Проте у Facebook спробували вирішити і цю задачу, поєднавши зусилля людей із алгоритмами.

У вересні цього Facebook запустив перевірку зображень і відео спільно з 27 партнерами в 17 країнах світу. У компанії повідомили, що алгоритми, які працюють на основі штучного інтелекту, відстежуватимуть медіаконтент і перевірятимуть його за кількома критеріями.

Серед них – зворотний зв’язок від користувачів (коментарі), а також непрямі ознаки проблемного контенту. Підозрілі фото надсилатимуть фактчекерам, які перевіряють їх, наприклад, аналізуючи метадані зображень або те, коли і де була зроблена фотографія або відео.

https://www.facebook.com/facebook/videos/2169674999973363/

У міру того, як компанія отримує більше оцінок від фактчекерів щодо фотографій і відео, компанія може підвищити точність її моделі машинного навчання. Іншими словами, робота фактчекерів і результати їхньої перевірки дозволяють навчати алгоритми автоматичному розпізнаванню фейкових і маніпулятивних зображень. Поряд з цим Facebook використовує й інші техніки, щоб краще розпізнавати помилковий або оманливий контент, наприклад, оптичне розпізнавання символів (OCR) для вилучення тексту з фотографій і порівняння цього тексту з заголовками статей.

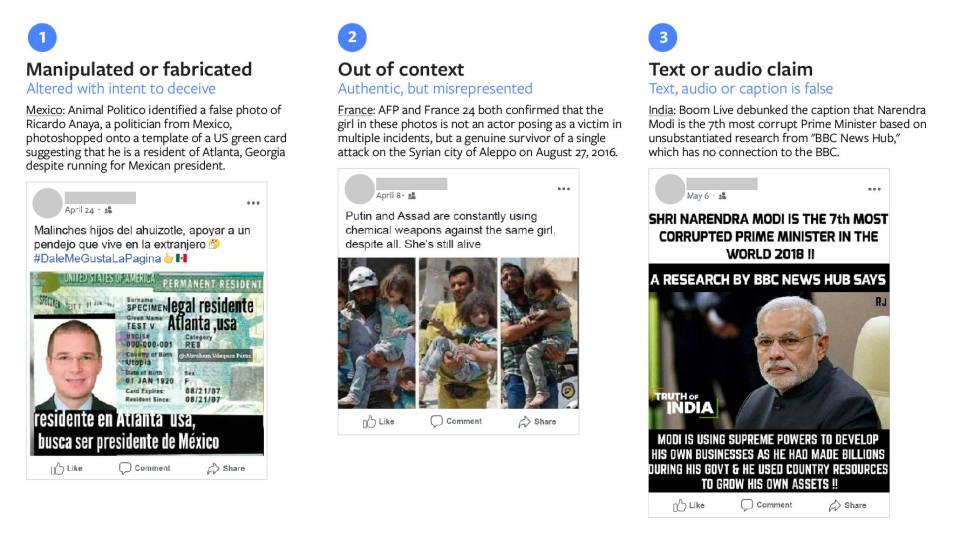

У Facebook зазначають, що дезінформація у фотографіях і відео зазвичай ділиться на три категорії:

– маніпулятивний або сфабрикований контент

– вирваний з контексту контент

– текст зображень, на яких розміщена брехлива інформація.

Компанія обіцяє, що підозрілі фото і відео, які отримали низькі оцінки і вважаються підозрілими щодо потенційного фейкового контенту, отримають спеціальне маркування.

Рейтинг довіри користувачів

Наприкінці літа Facebook ввів алгоритм, за допомогою якого компанія оцінює репутацію користувача і формує його умовну оцінку – рейтинг надійності або рейтинг довіри. У Facebook зазначають, що такий рейтинг допоможе компанії боротися з поширенням фейкових новин.

Алгоритм не тільки аналізуватиме призначений для користувача контент, а й враховуватиме скарги. Якщо користувачі скаржитимуться на чужі фейкові записи, їхній рейтинг буде зростати.

Примітно, що компанія не планує розкривати подробиці роботи цього алгоритму соцмережі, щоб користувачі не вдавалися до маніпулювання.

Що показали вибори

Насправді оцінити ефективність дій Facebook можна буде тільки у віддаленій перспективі. Не виключено, що через кілька місяців стане відомо про те, що чергове умовне Агентство інтернет-новин займалося активним вкиданням маніпулятивної реклами, яку не змогли ідентифікувати модератори та алгоритми соціальної мережі.

Поки ж у новинах з’явилася інформація про окремі випадки блокування облікових записів і видалення окремих матеріалів. Ця інформація може розцінюватися неоднозначно. З одного боку, це може свідчити про те, що найбільша соцмережа не впоралася, допустивши ближче до дати голосування існування і активну діяльність акаунтів, що поширюють фейки. З іншого, факт їх виявлення можна вважати демонстрацією ефективності інструментів і методик Facebook.

У жовтні стало відомо, що Facebook заборонить публікувати неправдиву інформацію щодо вимог до голосування і перевірку фактів підроблених повідомлень про насильство або довгі черги на виборчих дільницях.

Напередодні виборів компанія розповіла про свою підготовку до дня голосування і про те, що вона виявила 30 облікових записів Facebook і 85 облікових записів Instagram, які можуть брати участь у скоординованій недоброчесній поведінці, усіх їх було заблоковано. Із цими Facebook-акаунтами були пов’язані записи російською та французькою мовами.

Пізніше з’явилася інформація про блокування більше 800 сторінок і акаунтів користувачів за поширення фейків. Ці 559 сторінок і 251 аккаунт займалися розповсюдженням спаму і активізувалися якраз незадовго до проведення проміжних виборів у США.

Нові риторика, інструменти та підходи в боротьбі з фейками

Те, як відбувалася підготовка у Facebook до проміжних виборів, увага компанії до проблеми фейків, детальні повідомлення про те, що компанія робить і чому вона це робить – дуже важлива зміна і для соціальної мережі, і для всього інтернет-простору. Ігнорувати проблему фейків наразі вже не можна і, нарешті, в Facebook це зрозуміли і почали про це говорити. І говорити не завжди в розрізі знайомих для всіх понять на кшталт «тисячі і десятки тисяч модераторів контенту».

Компанія почала витрачати гроші на боротьбу з фейками, і не тільки у вигляді оплати роботи модераторів, а ще й на створення алгоритмів і інструментів визначення фейків. Навряд чи інвестори в захваті від таких витрат, ймовірно, досить значних і впливових на фінансові показники компанії, проте іншого шляху в умовах сьогодення у Facebook просто немає. Здатні до навчання алгоритми визначення фейків, хоч і працюють в тісній зв’язці з фактчекерами, напевно є предметом зацікавлення Facebook не лише як рішення, що допомагають визначити фейкові і маніпулятивні пости. Такі алгоритми допоможуть компанії і в розробці інструментів оцінки реклами, якості контенту та інших рішень, які Facebook пізніше зможе монетизувати.

Не виключено, що в компанії розуміють, що боротьба з фейками віднині для неї – нескінченне в часі завдання, яке їй доведеться вирішувати постійно. І постійно боротися з поліпшенням інструментів і навичок тих, хто ці фейки поширює.

Автор: Надія Баловсяк, для Stopfake.org.